递归式与和式

汉诺塔问题

三个柱子,$n$个面积互不相等的有孔圆盘一开始按照面积从上往下以此增大的顺序套在其中一个柱子上.

现在每次可以将某根柱子顶端的圆盘移动到另一根柱子顶端,要求这根柱子原本没有圆盘或者柱子顶端圆盘面积大于该圆盘.

求最小移动次数,使得所有圆盘移动到另一根柱子上.

不妨令$T_n$表示答案,显然$T_0 = 0 , T_1 = 1$.

而我们一定可以找到一种方案,使得前$n - 1$个圆盘先移动到其中一根柱子上,然后将最下面的圆盘移动到目标柱子,最后再把$n - 1$个圆盘移动到目标柱子.由于这是一个可行解而不一定是最优解,我们有:$T_n \leq 2 T_{ n - 1 } + 1$.

而如果我们要移动最大的圆盘,一定要保证前n-1个圆盘已经移走到一根柱子上.因此一定有:$2 T_{ n - 1 } + 1 \leq T_n$.于是有$T_n = 2 T_{ n - 1 } + 1$.

Example1(《具体数学》1.2)

汉诺塔问题,所有圆盘一开始均在最左边的塔A上,要将他们全都移动到最右边的塔C上,不允许在二塔之间直接移动,求最小操作次数.

Solution 1

考虑设$T_n$为n个圆盘时的最小操作次数.假设已知$T_{ n - 1 }$,我们考虑如何移动.

首先因为不能直接在AC之间移动,因此一定是先要把最大的圆盘移动到中间塔上,这一步要求先把所有圆盘移动到C上,然后需要再把这些圆盘移动回A上,因此,显然有:$T_{ n } = 3 T_{ n - 1 } + 2 , T_0 = 0$.

考虑如何求该式子的封闭形式,令$W_n = T_n + 1$,显然有$W_n = 3 W_{ n - 1 } , W_0 = 1$,显然$W_n = 3^n$,有$T_n = 3^n - 1$.

注意到$T_n$刚好是三根柱子上所有合法排列的数量,并且这个过程中不可能出现某两个时刻的情况是相同的,因此1.3也可以证明.

Example2(《具体数学》1.4)

汉诺塔问题,问是否存在一种符合规则的初始摆放方式,使得将其全部移动到其中一根柱子所用次数小于等于$2^n - 1$.

Solution 2

不存在.

证明方式类似原初问题的证明,考虑最大的那个圆盘是否到达终点.如果到达则可以去掉它,用数学归纳证明不存在;如果还未到达,同样用数学归纳得到不等式.

Example3(《具体数学》1.10)

汉诺塔问题,但是移动圆盘时只能从A移动到B,从B移动到C,从C移动到A.一开始所有圆盘都在A,求将它们全部移动到B的最小操作次数,以及将他们从B移动回A的最小操作次数.

Solution 3

令$Q_n$为将n个圆盘从A移动到B的最小操作次数,令$R_n$为将n个圆盘从B移动回A的最小操作次数.

先考虑边界情况,$Q_0 = 0 , R_0 = 0$.

我们考虑,由于柱子间在移动过程中是无区别的,因此$Q_n$的实质是将n个圆盘移动到它的下一个柱子的最小操作次数,$R_n$的实质是将n个圆盘移动到它的上一个柱子的最小操作次数.

在将最大的圆盘移动到下一根柱子前,一定要先把上面的圆盘全部移动到上一根柱子上,最后再移动回来.

显然有$Q_n = 2 R_{ n - 1 } + 1 , 1 \leq n$.

在将最大的圆盘移动到上一根柱子前,一定要先把他移动到下一根柱子上,这个步骤要求我们把其他的圆盘移动到上一根柱子上.在这之后,我们又要把所有圆盘放到上一根柱子上来让最大圆盘到目标柱子,最后再移动回来.

有$R_n = R_{ n - 1 } + 1 + Q_{ n - 1 } + 1 + R_{ n - 1 } = Q_n + Q_{ n - 1 } + 1 , 1 \leq n$.

Example4(《具体数学》1.11)

汉诺塔问题,但是每种大小的圆盘有两个,且其中一个可以摆放在另一个的上面.

a.如果相同圆盘无区别,求最小操作次数.

b.如果相同圆盘有区别,且最后需要还原原本二者的上下顺序,求最小操作次数.

Solution 4

a.仍然令$T_n$为n对圆盘的最小操作次数,显然$T_n = 2 T_{ n - 1 } + 2 , T_0 = 0$,可解得$T_n = 2^{ n + 1 } - 2$.

b.令$Q_n$为n对圆盘的最小操作次数,观察a问题,我们可以发现a问题转移之后,只有最下面的两个圆盘会交换顺序.而如果我们在b问题中只关注最下层两个圆盘的顺序,我们发现$Q_n = T_{ n - 1 } + 1 + T_{ n - 1 } + 1 + T_{ n - 1 } + 1 + T_{ n - 1 } = 4 T_{ n - 1 } + 3 = 2^{ n + 2 } - 5$.

我们进行了四次a操作,那么次下面两个圆盘自然就顺序与原本相同了,因此这里的$Q_n$就是答案.

Example5(《具体数学》1.12)

类似Problem11,但第$i$大的圆盘有$k_i$个.

Solution 5

无区别,只是$T_n = 2 T_{ n - 1 } + k_n , T_0 = 0$.

如果求封闭形式的话,显然有$T_n = \sum_{ i = 1 }^n 2^{ n - i } k_i$.

递归式的封闭形式

在上述问题中,我们已经有了以下式子:

$T_n = 2 T_{ n - 1 } + 1 , n > 0 , T_0 = 0$.

如果$n$很大,那么一步一步去计算是很复杂的,现在我们想知道一种更为快速的求出$T_n$的方法.

换句话说,我们想要把$T_n$表示为只与n有关的式子,我们称其为该递归式的封闭形式.

寻找循环节

Example(《具体数学》1.8)

解递归式:$Q_n = \begin{cases}\alpha & n = 0 \ \beta & n = 1 \ \frac{ ( 1 + Q_{ n - 1 } ) }{ Q_{ n - 2 } } & n > 1\end{cases}$,保证$\forall n , Q_n > 0$.

Solution

注意到$Q_2 = \frac{ \beta + 1 }{ \alpha } , Q_3 = \frac{ \beta + \alpha + 1 }{ \beta \alpha } , Q_4 = \frac{ 1 + \alpha }{ \beta } , Q_5 = \alpha , Q_6 = \beta$.

显然该递归式存在长度为$5$的循环节.

数学归纳法

观察T序列的前几项,可以发现似乎有$T_n = 2^n - 1$.

现在我们来证明它:

1.该公式对于$n = 0$成立,显然可验证.

2.若该公式对$n = k$时成立,那该公式必然对$n = k + 1$成立.

因为有$T_{ k + 1 } = 2 T_k + 1 = 2 \times 2^k + 2 - 1 = 2^{ k + 1 } - 1$.

以上过程被称为数学归纳法.

Example(《具体数学》1.9)

求证:$\prod_{ i = 1 }^n x_i \leq ( \frac{ \sum_{ i = 1 }^n x_i }{ n } )^n , \forall i \in N_+ , 1 \leq i \leq n , 0 \leq x_i$.

Solution

使用反向归纳法.

1.$n = 2$时,即基本不等式,显然成立.

2.若该式子对$n = k$时成立,则该式子对n=2k时也成立.

不妨令$A_1 = \sqrt[k]{ \prod_{ i = 1 }^k x_i } , B_1 = \sqrt[k]{ \prod_{ i = k + 1 }^{ 2 k } x_i } , A_2 = ( \frac{ \sum_{ i = 1 }^k x_i }{ k } ) , B_2 = ( \frac{ \sum_{ i = k + 1 }^{ 2 k } x_i }{ k } )$,显然有$A_1 \leq A_2 , B_1 \leq B_2$.

同时有$( \frac{ A_2 + B_2 }{ 2 } ) \geq \sqrt{ A_2 B_2 } \geq \sqrt{ A_1 B_1 }$.

3.若该式子对$n = k$时成立,则该式子对$n = k - 1$的时候也成立.

令$x_k = \frac{ \sum_{ i = 1 }^{ k - 1 } x_i }{ k - 1 }$,有$x_k \prod_{ i = 1 }^{ k - 1 } x_i \leq ( x_k )^k$.

则显然$n = k - 1$时也成立.

由1和2,我们知道了对于n是二的整数次幂的情况,该公式成立,由3,我们又可以知道该公式对于任意一个存在比他大的二的整数次幂的数成立,因此该公式成立.

换元

考虑令$U_n = T_n + 1$,显然有:$T_n + 1 = 2 T_{ n - 1 } + 2$.即$U_n = 2 U_{ n - 1 }$,显然$U_n = 2^n$,则$T_n = 2^n - 1$.

这个做法可以做掉所有形如$a_{ n + 1 } = pa_n + q$的递归式.我们有:

换元做掉这个式子.

转化和式

考虑递归式$a_n T_n = b_n T_{ n - 1 } + c_n$.如果我们能找到一个不为0的求和因子$s_n$并满足$s_n b_n = s_{ n - 1 } a_{ n - 1 }$.那么我们两面同时乘以$s_n$,显然有:$s_n a_n T_n = s_{ n - 1 } a_{ n - 1 } T_{ n - 1 } + c_n s_n$.

令$S_n = s_n a_n T_n$.显然有$S_n = s_0 a_0 T_0 + \sum_{ i = 1 }^n s_i c_i$,则$T_n = \frac{ S_n }{ s_n a_n }$.

而我们也会发现$s_n = \frac{ \prod_{ i = 1 }^{ n - 1 } a_i }{ \prod_{ i = 1 }^n b_i }$.

Example1(快速排序时间复杂度)

结论:排序$n$个数时,其期望复杂度满足:

不妨考虑两边同时乘以$n$,有 $nC_n = n^2 + n + 2 \sum_{ i = 0 }^{ n - 1 } C_i , n > 1$ .

显然也有$( n - 1 ) C_{ n - 1 } = ( n - 1 )^2 + n - 1 + 2 \sum_{ i = 0 }^{ n - 2 } C_i , n > 2$.

二式相消,有$nC_n - ( n - 1 ) C_{ n - 1 } = 2 n + 2 C_{ n - 1 } , n > 2$.

而同时有$C_2 = 3$.即:$nC_n = ( n + 1 ) C_{ n - 1 } + 2 n , n > 2$,可以使用转化和式的方法,两边乘以$\frac{ 1 }{ n ( n + 1 ) }$解决.

Example2

已知$a_1 = 1$,$a_n = \sqrt{ S_n } + \sqrt{ S_{ n - 1 } }$,求$a_n$.

注意到$a_n = S_n - S_{ n - 1 }$,则有$\sqrt{ S_n } - \sqrt{ S_{ n - 1 } } = 1$,于是$\sqrt{ S_n } = n$,$S_n = n^2$,$a_n = 2 n - 1$.

成套方法

如果我们有

\alpha & n=1\\

2f(\frac n 2)+\beta & n=2k,k\in \mathbb{N_+}\\

2f(\frac {n-1}2)+\gamma &n=2k+1,k\in \mathbb{N_+}

\end{cases}

其中$n = 2^m + l$且$2^m \leq n < 2^{ m + 1 }$.

该如何求出$f ( n )$的封闭形式呢?

由于所有的未知数都是以加法运算连接,显然有$f ( n ) = A ( n ) \alpha + B ( n ) \beta + C ( n ) \gamma$,而有$A 、 B 、 C$互不影响且$\alpha \beta \gamma$与$ABC$无关.

那无论$\beta$和$\gamma$的取值如何,$A ( n )$都不会受到影响,我们考虑$\beta = \gamma = 0$的特殊情况,此时显然有$A ( n ) = 2^m$.

接下来,我们考虑取$\alpha \beta \gamma$的特殊值,去得到ABC之间的关系.

例如,当$f ( n ) = 1$时,由递推式可知$\alpha = 1 , \beta = \gamma = - 1$,那么有$A ( n ) - B ( n ) - C ( n ) = f ( n ) = 1$.

同理,$f ( n ) = n$时,可知$\alpha = 1 , \beta = 0 , \gamma = 1$,此时有$A ( n ) + C ( n ) = f ( n ) = n$.

显然可以通过解方程求得$B ( n )$和$C ( n )$.

这个方法显然是通用方法,式子仅仅是例子,事实上,只要我们能证明$ABC$互不影响且$\alpha \beta \gamma$与$ABC$无关,我们就可以使用这个方法.

这个东西的原理是什么呢?显然是因为其中存在一个线性无关性对吧.

线性递推

一个常系数的$k$阶线性递推关系形如:

当$P = 0$时,称作齐次线性递推.

特征方程

我们称方程$r^k = \sum_{ i = 1 }^k c_i r^{ k - i }$是该递推关系的特征方程,方程的解叫做该递推关系的特征根.

二阶线性齐次递推

若其特征方程有两个不同的根$r_1$和$r_2$,那么存在两个常数$\alpha_1$和$\alpha_2$,满足$a_n = \alpha_1 r_1^n + \alpha_2 r_2^n$.

若其特征方程有两个相同的根$r$,那么存在两个常数$\alpha_1$和$\alpha_2$,满足$a_n = \alpha_1 r^n + \alpha_2 nr^n$.

先考虑前者的证明,首先考虑对于$n = 0$或者$n = 1$的情况,我们考虑求出一组$\alpha_1$和$\alpha_2$来满足:

若$r_1 \ne r_2$,可以解得:

接下来考虑数学归纳:

接下来考虑后者,首先我们有$\Delta = c_1^2 + 4 c_2 = 0$,考虑初始条件:

接下来我们考虑数学归纳:

我们接下来只需证明$c_1 r + 2 c_2 = 0$即可.根据方程,不难发现$r = \cfrac{ c_1 }{ 2 }$,根据$\Delta = 0$,自然得证.

更一般的情况

直接在复数域上定义$f_k ( x ) = \{ n^k x^n \}_{ n = 0 }^\infty$,此时我们规定$0^0 = 1$.特别地,当$x = 0$的时候,定义$f_k ( x )$的第$k$项是$1$,其余项是$0$.在此基础上定义线性映射$T : ( a_n )_{ n = 0 }^\infty \mapsto ( a_{ n + 1 } )_{ n = 0 }^\infty$,立刻见到:$( T - x )^{ k + 1 } f_k ( x ) = 0 , ( T - x )^k f_k ( x ) \ne 0$.原因只需简单数学归纳.而此还可以引出$f_0 ( x ) , f_1 ( x ) , \cdots$线性无关.

在此基础上观察线性递推$a_{ n + d } = c_{ d - 1 } a_{ n + d - 1 } + \cdots + c_0 a_n$,不妨取$G ( x ) = x^d - c_{ d - 1 } x^{ d - 1 } - \cdots - c_0$,立刻应当见到如果$a$是$G$的根并且重数为$e ( a )$,那么$f_{ 0 } ( x ) , \cdots , f_{ e ( a ) - 1 } ( a )$都在$\ker f ( T )$中.这恰好是该线性递推空间的维数个.我们需要说明它们线性无关,不妨反证,假设出现了形如$\sum_j w_i f_i ( y ) = \sum_j w_j f_j ( x )$的情况,此时对右边直接操作若干次$( T - x )$就可以把右边全部消成$0$,在对着左边消几次就可以使得左边只留下最高次项,这个时候发现最高次项是消不掉的,原因是将每一个位置看作关于$n$的多项式右边的$( T - x )$是不会改变左边这边的每一个位置多项式的$\deg$,这当然意味着不可能消干净.

再再进一步

我们都知道矩阵加速:也就是$\vec{ x }_{ k + 1 } = A \vec{ x }$,$\vec{ x }_{ n } = A^n \vec{ x }_0$.而我们又知道CH定理:$p ( A ) = 0$,我们用多项式取膜,有$A^n = p ( A ) F ( A ) + G ( A ) = G ( A )$,这就是解.

约瑟夫问题

考虑n个人围成一圈,从第一个人开始,每隔一个人就杀掉一个人.如10个人围成一圈时,杀人的顺序是$2 , 4 , 6 , 8 , 10 , 3 , 7 , 1 , 9$.问最后幸存下来的人编号.

首先一定有J(1)=1.考虑第一遍杀掉n号或者n-1号之后,对整个圆圈进行重新编号.

那么当人数是偶数时,我们有$J ( 2 n ) = 2 J ( n ) - 1$;当人数是奇数时,我们杀掉一号,然后有$J ( 2 n + 1 ) = 2 J ( n ) + 1$.

整理得到:

仍然可以使用数学归纳,如果令$n = 2^m + l 且 2^m \leq n < 2^{ m + 1 }$.

有$J ( n ) = 2 l + 1$.

要是注意力没有那么集中怎么办呢?考虑到这个东西显然和取膜有着不可分割的关系,我们不妨从$0$开始编号:

这下相信$J ( n )$是多少就很显然了,将$n$写成二进制的形式,这个就相当于把首位$1$抹去然后在末尾加个$0$.

Example(《具体数学》1.15)

求约瑟夫问题中最后一名被杀死的人的编号.

Solution

显然有:

从$0$开始编号,自然有:

显然$J ( n )$也可以用二进制表达其形式.

和式

和式的基本运算

分配律:

一般分配律:

结合律:

交换律:

交换求和顺序:

和式的封闭形式

交换顺序法

Example1(等差数列求和)

我们有:

Example2(切比雪夫单调不等式)

令$S = \sum_{ 1 \leq i < j \leq n } ( a_j - a_i ) ( b_j - b_i ) = \sum_{ 1 \leq j < i \leq n } ( a_j - a_i ) ( b_j - b_i )$.

考虑恒等式$[ 1 \leq j < i \leq n ] + [ 1 \leq i < j \leq n ] = [ 1 \leq j , i \leq n ] - [ 1 \leq i = j \leq n ]$.

那么我们有:

显然有以下式子:

(\sum_{i=1}^na_i)(\sum_{j=1}^nb_j)\geq n\sum_{i=1}^na_ib_i,\forall i<j,a_i\leq a_j且b_i\geq b_j\\

上式被称为切比雪夫单调不等式.

值得一提的是,切比雪夫单调不等式其实是排序不等式的一个特化版本.

Example3(拉格朗日恒等式)

证明:

有:

扰动法

Example1(等比数列求和)

而$S_{ n - 1 } + ax^n = S_n = a + xS_{ n - 1 }$,有$S_n + ax^{ n + 1 } = a + xS_n , S_n = a \frac{ x^{ n + 1 } - 1 }{ x - 1 }$,其中$x \ne 1$.

Example2(平方和公式)

如果直接对该公式使用扰动法:

我们无法得到$S_n$的封闭形式,但我们发现我们得到了$\sum_{ i = 1 }^n i$的封闭形式.

那以此类推,我们设$W_n = \sum_{ i = 0 } i^3$.

Example3(《具体数学》2.20)

令$H_n = \sum_{ k = 1 }^n \frac{ 1 }{ k }$,求$\sum_{ i = 0 }^n H_i$.

Solution3

不妨考虑$\sum_{ i = 0 }^n iH_{ i }$的值.

Example4(《具体数学》2.21)

求$S_n = \sum_{ i = 0 }^n ( - 1 )^{ n - i } , T_n = \sum_{ i = 0 }^n ( - 1 )^{ n - i } i , U_n = \sum_{ i = 0 }^n ( - 1 )^{ n - i } i^2$.

Solution 4

转化为递归式

考虑和式$S_n = \sum_{ i = 0 }^n f ( i ) = S_{ n - 1 } + f ( n ) \\$,显然是递归式形式.

因此递归式所可以使用的方法同样可以在和式中使用.

Example1(《具体数学》2.13)

求$\sum_{ i = 0 }^n ( - 1 )^i i^2 \\$.

Solution1

令$S ( n ) = \sum_{ i = 0 }^n ( - 1 )^i i^2 = S ( n - 1 ) + ( - 1 )^n n^2$,考虑使用成套方法.

不妨令$S ( n ) = S ( n - 1 ) + ( - 1 )^n ( \alpha + \beta n + \gamma n^2 ) = \alpha A ( n ) + \beta B ( n ) + \gamma C ( n )$.

令$S ( n ) = ( - 1 )^n n , 可 以 解 得 \alpha = - 1 , \beta = 2 , \gamma = 0$,有$( - 1 )^n n = - A ( n ) + 2 B ( n )$.

令$S ( n ) = ( - 1 )^n n^2 , 可 以 解 得 \alpha = 1 , \beta = - 2 , \gamma = 2$,有$( - 1 )^n n^2 = A ( n ) - 2 B ( n ) + 2 C ( n )$.

显然可解得$2 C ( n ) = ( - 1 )^n n^2 + ( - 1 )^n n , C ( n ) = ( - 1 )^n \frac{ n ( n + 1 ) }{ 2 }$.

而原式中,$S ( n ) = C ( n ) = ( - 1 )^n \frac{ n ( n + 1 ) }{ 2 }$.

Example2(《具体数学》2.19)

有$2 T_n = nT_{ n - 1 } + 3 n ! , T_0 = 5$,求$T_n$.

Solution 2

令$s_n = \frac{ 2^{ n - 1 } }{ n ! }$,两边同时乘以$s_n$,有$\frac{ 2^n }{ n ! } T_n = \frac{ 2^{ n - 1 } }{ ( n - 1 ) ! } T_{ n - 1 } + 3 \times 2^{ n - 1 } \\$.

令$S_n = \frac{ 2^n }{ n ! } T_n$,有:

转化为积分形式

Example1(平方和公式)

考虑先求出一个近似解,然后再求误差.

考虑函数$f ( x ) = x^2$,显然$\int_0^n x^2 dx = \frac{ n^3 }{ 3 } \sim S_n \\$.

接下来,我们考虑求得二者之间的误差,设$E_n = S_n - \frac{ n^3 }{ 3 } \\$,对其使用扰动法:

这样就得到了递归式,可以求得封闭形式.

还有一种方法是:

这是一个简单的和式.而$S_n = E_n + \frac{ n^3 }{ 3 } \\$,显然也可以求得.

Example2(某浙江高考题)

已知$a_1 = 1 , a_{ n + 1 } - a_n = - \frac{ 1 }{ 3 } a_n^2$,估计$a_n$的值.

考虑构造一个函数$f ( n )$使得$f ( n ) \approx a_n$,那我们就可以将$a_{ n + 1 } - a_n \approx f_n$.

这个第一眼看上去就很有道理,而事实上也确实很有道理,原因是根据拉格朗日中值定理,$\exists x_0 \in [ n , n + 1 ] , f ‘ ( x_0 ) = f ( n + 1 ) - f ( n )$,而对于增长率变化不大的函数,直接认为$f ‘ ( x_0 ) = f ‘ ( n )$是有理可循的!

然后,原式子就变成了一个微分方程了,带入$f ( 1 ) = 1$解得$f ( n ) = \frac{ 3 }{ n + 2 }$.这个精度已经足够选出来原本的放缩题的答案了.

令$a_n = \frac{ 3 }{ n + 2 } - b_n$,带入化简,得到$\{ b_n \}$的递推式:

算到这里,我们可以很轻易使用数学归纳法算出$b_n \leq \frac{ 1 }{ 4 n }$,这个精度已经挺不错的了,但是也让人觉得很不满意,因为这个误差项怎么和估计项是同阶的啊.

然后我开始估计了一下这个$b_n$的阶,因为我其实没学过什么高超的高数技巧,所以我使用了OI的一些技巧来估计,不妨假设$b_n^2 < < b_n$:

那么这个$b_n$是$O ( \frac{ \ln n }{ n^2 } )$级别的.

如何理解这个级别?考虑别乱动$b_n$的系数,我们有:

这警戒我们以后乱估计的时候千万别把$O ( n^{ \epsilon } )$和$O ( 1 )$搞混了,警钟长鸣.

这个时候大概估计一下会发现$b_n \leq \frac{ 3 \ln n }{ n ( n + 1 ) }$.

展开和收缩

Example1(平方和公式)

我们有:

整理得到$S_n$.

Example2(《具体数学》2.14)

求$\sum_{ i = 1 }^n i 2^i \\$.

Solution 2

Example3(《具体数学》2.15)

求$\sum_{ i = 1 }^n i^3 \\$.

Solution 3

ExampleEX

求$\sum_{ i = 1 }^n iq^i ( q \ne 1 )$.

SolutionEX

ExampleEX2

求$\sum_{ i = 1 }^n ( ai + b ) q^{ i - 1 } ( q \ne 1 )$.

SolutionEX2

令$A = \frac{ a }{ q - 1 } , B = \frac{ b - A }{ q - 1 }$,答案为$( An + B ) q^n - B$.

有限微积分

移位算子

定义移位算子$E$,使得$Ef ( x ) = f ( x + 1 )$.

差分算子

定义差分算子$\Delta f ( x ) = f ( x + 1 ) - f ( x )$,类似于无限微积分中的D算子.

另外,不难发现有$\Delta = E - 1$.

逆差分算子

定义逆差分算子$\Sigma$,可以得到有限微积分的基本定理:

这里的$\Sigma$又被称为不定和式,是差分等于$g$的一个函数类.

值得一提的是,这里的$C$与无限微积分中的$C$有一定区别,这里的$C$可以是满足$p ( x ) = p ( x + 1 )$的任意一个函数而不非得是常数函数.

定和式

如果$g ( x ) = \Delta f ( x )$,那么有$\sum \nolimits_{ a }^b g ( x ) \delta x = f ( x ) |^{ b }_a = f ( b ) - f ( a ) \\$.

值得一提的是,如果$a \leq b$,显然有$\sum \nolimits_{ a }^b g ( x ) \delta x = \sum_{ x = a }^{ b - 1 } g ( x ) \\$.

但如果$a > b$,那么$\sum \nolimits_{ a }^b g ( x ) \delta x = - \sum \nolimits_b^a g ( x ) \delta x \\$.

事实上,我们一定有:$\sum \nolimits_a^b g ( x ) \delta x + \sum \nolimits_b^c g ( x ) \delta x = \sum \nolimits_a^c g ( x ) \delta x \\$.

一些基本的公式

类比无限微积分中的$D ( x^m ) = mx^{ m - 1 }$,有:

类比无限微积分中的$D ( \ln x ) = \frac{ 1 }{ x }$,有:

类比无限微积分中的$D ( e^x ) = e^x$,有:

根据组合数公式,有:

Example(平方和公式)

我们有:$k^2 = k^{ \underline{ 2 } } + k^{ \underline{ 1 } } \\$.

那么:

整理即可得到封闭形式.

值得一提的是:

与前面的方法不同,这里没有使用三次的二项式公式,而是使用了二次的斯特林公式负责将一般幂转化为下降幂.

高阶差分

考虑一阶差分是$\Delta f ( x ) = f ( x + 1 ) - f ( x )$,那么二阶差分就是$\Delta^2 f ( x ) = f ( x + 2 ) - 2 f ( x + 1 ) + f ( x )$.

类似地,我们可以通过归纳法证明$\Delta^n f ( x ) = \sum_{ k } \binom{ n }{ k } ( - 1 )^{ n - k } f ( x + k ) \\$.

事实上有一种更简单的证明方法,由于$\Delta = E - 1$,于是$\Delta^n = ( E - 1 )^n = \sum_{ k } \binom{ n }{ k } ( - 1 )^{ n - k } E^k \\$,由于$E^k f ( x ) = f ( x + k )$,即可证明原式.

另外,不难发现如果$f ( x )$是一个关于$x$的$d$次多项式,那么$\Delta f ( x )$是一个$d - 1$次多项式.同理,$\Delta^d f ( x )$会是一个常数而$\Delta^{ d + 1 } f ( x )$会是$0$,这个发现引出了牛顿级数.

Example([yLOI2020]灼)

首先不难发现对于一个位置,有意义的只有相邻的两个虫洞,设这两个位置分别为$x_1 , x_2$.

不难写出期望转移式子:$f_i = \cfrac{ 1 }{ 2 } ( f_{ i - 1 } + f_{ i + 1 } ) + 1$,并且$f_{ x_1 } = f_{ x_2 } = 0$.

接下来如何做呢?

我们先对第一个式子进行变形:

$f$的二阶差分是常数,也就是说$f$是二次多项式,不难求得其二次项系数为$- 1$又知道两个零点,显然可以得到$f$的表达式.

牛顿级数

令$f ( x ) = \sum_{ 0 \leq i \leq d } a_i x^i \\$.而由于有斯特林数可以进行幂和下降幂的转换,则我们可以将其改写为$f ( x ) = \sum_{ 0 \leq i \leq d } b_i x^{ \underline{ i } } \\$.

我们设$c_i = i ! b_i$,于是有:$f ( x ) = \sum_{ 0 \leq i \leq d } c_i \binom{ x }{ i } \\$.

也就是说,任何多项式都可以表示为二项式系数的倍数之和,我们称这样的展开式为$f ( x )$的牛顿级数.

于是不难发现有:$\Delta^n f ( x ) = \sum_{ 0 \leq i \leq d } c_i \binom{ x }{ i - n } \\$.如果我们令$x = 0$,则有:$\Delta^n f ( 0 ) = \begin{cases}c_n & n \leq d \ 0 & n > d\end{cases}$.那么牛顿级数的另一种表示即:$f ( x ) = \sum_{ 0 \leq i \leq d } \Delta^i f ( 0 ) \binom{ x }{ d } \\$.

另外,如果我们展开一下$c_n = \Delta^n f ( 0 )$,我们可以得到公式:

$\sum_{ k } \binom{ n }{ k } ( - 1 )^k ( \sum_{ 0 \leq i \leq n } c_i \binom{ k }{ i } ) = ( - 1 )^n c_n , n \in \mathbb{ N } \\$.

如果我们将多项式还原,由于$a_n = b_n$,有:

$\sum_{ k } \binom{ n }{ k } ( - 1 )^k ( \sum_{ 0 \leq i \leq n } a_i k^i ) = ( - 1 )^n n ! a_n , n \in \mathbb{ N } \\$.

另外,如果$x \in \mathbb{ N }$,那么我们有:$f ( x ) = \sum_{ 0 \leq k } \Delta^k f ( 0 ) \binom{ x }{ 0 }$,根据多项式推理法,这个公式对$\forall x \in \mathbb{ Z }$都成立.

于是我们可以类似泰勒级数写出无限牛顿级数:

Example

求$\sum_{ k } \binom{ n }{ k } \binom{ r - sk }{ n } ( - 1 )^k , n \in \mathbb{ N } \\$.

如果我们令$f ( k ) = \binom{ r - sk }{ n } = \sum_{ 0 \leq i \leq n } a_i k^i \\$,不难发现$a_n = \cfrac{ ( - 1 )^n s^n }{ n ! }$,于是显然原式$= s^n$.

分部求和法则(Abel求和法)

两边取不定和,即可得到分部求和法则:

$\sum u \Delta v = uv - \sum Ev \Delta u \\$.

分部求和用一般和式表达如下,下式又被称为Abel求和法:

对于$l = 0 , r = n , a_0 = b_0 = 0$的特殊情况,应当有:

取两组数列$\alpha , \beta$,并令$\sum_{ i = 1 }^n \beta_i = B_i$,立刻有:

Example1

求$\sum_{ k = 0 }^n k 2^k \\$.

根据分部求和法则,我们有:

$\sum x 2^x \delta x = x 2^x - \sum 2^{ x + 1 } \delta x = x 2^x - 2^{ x + 1 } + C \\$.

改为定和式形式,显然有:

$\sum_{ k = 0 }^n k 2^k = \sum \nolimits_0^{ n + 1 } x 2^x \delta x = ( n + 1 ) 2^{ n + 1 } - 2^{ n + 2 } + 2 = ( n - 1 ) 2^{ n + 1 } + 2 \\$.

Example2

求$\sum_{ k = 0 }^{ n - 1 } kH_k \\$.

令$u ( x ) = H_x , v ( x ) = \frac{ 1 }{ 2 } x^{ \underline{ 2 } } \\$.

带入分部求和法则,显然有:

$\sum xH_x \delta x = \frac{ x^\underline{ 2 } }{ 2 } H_x - \frac{ x^\underline{ 2 } }{ 4 } + C \\$.

带入即可求出原式$= \frac{ n^\underline{ 2 } }{ 2 } ( H_n - \frac{ 1 }{ 2 } ) \\$.

Example3(《具体数学》2.23)

求$\sum_{ i = 1 }^n \frac{ 2 i + 1 }{ i ( i + 1 ) } \\$.

Solution 3

令$u = ( 2 n + 1 ) , v = - \frac{ 1 }{ i }$,则$\Delta u = 2 , \Delta v = \frac{ 1 }{ i ( i + 1 ) }$.

根据分部求和法则,有:

Problem 4(《具体数学》2.24)

求$\sum_{ i = 0 }^{ n - 1 } \frac{ H_k }{ ( k + 1 ) ( k + 2 ) } \\$.

Solution 4

令$u = H_n , v = - \frac{ 1 }{ n + 1 } , \Delta u = \frac{ 1 }{ n + 1 } , \Delta v = \frac{ 1 }{ ( n + 1 ) ( n + 2 ) } \\$.

根据分部求和法则,有:

贪心与构造

贪心

排除不优策略

Example1(CF1612E)

先把期望写开,我们发现如果选择了$t$个消息$a_1 , a_2 , . . . , a_t$,那么答案就是$\sum [ \exists j , m_i = a_j ] \cfrac{ \min ( t , k_i ) }{ t }$.显然如果$t$固定,那么每个$a_j$的贡献是独立的.于是只需要枚举$t$然后取贡献最大的.

但是,如果$t > \max \{ k_i \}$,这个时候$t - 1$的答案是$t - 1$个数之和除以$t - 1$,$t$的答案是这$t - 1$个数之和加上另一个更小的数除以$t$,而前者肯定比后者大,于是不用再进一步枚举.

于是复杂度$O ( n \max \{ k_i \} )$.

Example2(CF1592F1)

首先,二操作和三操作一定没有用,因为它们都可以用两次一操作代替.

再注意到四操作是可能有用的,因为我们拿一操作模拟四操作需要四金币的代价,而用一个四操作只需要三个金币.但是,由于拿一操作模拟四操作的时候,需要全局做一遍一操作,所以如果有两个四操作,模拟的时候两遍全局操作就可以抵消.因此,我们模拟两次四操作只需要六个金币的代价.换句话说,我们如果要用到四操作,只会使用一次或零次.

首先区间异或可以差分($b_{ i , j } = a_{ i , j } \oplus a_{ i + 1 , j } \oplus a_{ i , j + 1 } \oplus a_{ i + 1 , j + 1 }$)后转化为四个点的异或操作,而由于一操作操作了左上角的矩阵,所以它实际上是对三个在原矩阵外的点和一个在矩阵内的点操作.我们注意到如果矩阵内已经全都是$0$了,那么矩阵外不可能是$1$,也就是原矩阵也全都是$0$了.

枚举一下最后的操作是啥即可,另外注意到这一步操作必须把四个点全部变成$0$才有用,不然还需要拿一操作去补,就不如直接用一操作.

Example3(CF1592F2)

首先注意到,如果我们对$( x , y )$使用操作四,那我们不可能再对一个$( x , i )$使用操作四,不然我们就可以用四次操作一代替这两次操作四.

再通过上面的分析,注意到只有$b_{ x , y } , b_{ n , y } , b_{ x , m }$都是$1$的时候才会使用四操作,不然,如果我们使用四操作,必然会再需要一个一操作来补,这样就是至少三个金币的代价.而由于这四个点中最多只有三个$1$,所以一定不如直接用一操作来的划算.不然,如果三个都是$1$,那么用了就一定不亏,因为无论如何也需要三次一操作,而就算我们用完后$b_{ n , m }$变成$1$了,再不行也可以使用一次$1$操作来补全.

因此我们现在想要选尽可能多的三操作,满足两两操作不在同一行或同一列,这显然是一个二分图匹配问题.换句话说,如果$b_{ x , y } , b_{ n , y } , b_{ x , m }$都是$1$,我们就把$x$到$y$连一条边,然后做二分图匹配,显然是最优的.

Example4(CF1666E)

先想一下别的东西怎么求.

如果我们要求最大值最小或者最小值最大怎么办?我们可以二分后贪心,而显然它们的差就是一个答案的下界,问题在于这个下界是否可以取到.

我们冷静一下,发现在可能的方案中,第$i$条线段的右端点的位置一定是一段连续的区间.

设$f_i$表示第$i$个分界点可能的最小值,$g_i$表示第$i$个分界点可能的最大值.假设我们目前二分的最大值要小于等于$mx$,最小值要大于等于$mn$,那么我们有转移:

注意到$f$与$g$的转移是无关的,而显然对于第$i$个分界点,它可以取$[ f_i , g_i ]$中一个数,一定存在一个取法使得答案能取到下界.

为啥呢?只需让$ans_{ i }$表示第$i$条分界线是啥,那么我们$ans_i$是可以取$[ ans_{ i + 1 } - mx , ans_{ i + 1 } - mn ]$中的任何一个数字的,我们将其和上面求出的$[ f_i , g_i ]$求一下交集.如果交集为空,说明要么$ans_{ i + 1 } - mn < f_i , f_{ i + 1 } < ans_{ i + 1 } < f_i + mn$,这是不可能的.另一种情况同理不可能,这就保证了一定可以取到答案.一定能使极差$\leq mx - mn$.

Example5(2022zrtg十连测day7 Palindrome)

首先注意到同种字符的相对顺序不可能改变.于是最后的回文串是哪个字符对应哪个字符就可以确定.

这样我们的问题转化为现在有若干个点对$( l , r )$,我们想给每一个点对赋值:$a_l = i , a_r = n - i + 1$(注意如果$n$是奇数,那么中心点应该是$a_{ mid } = \frac{ n + 1 }{ 2 }$),然后使整个序列逆序对数尽可能小.

接下来讨论一下两个点对$( l_1 , r_1 )$,$( l_2 , r_2 )$之间的三种可能的关系:不交,包含,相交且不包含.会发现若$l$小则让$a_l$尽可能小就是最优的.

Example6(23省选10连测 day9 C)

强强题.

首先发现这个$\pm 1$操作很奇怪.我们不妨这么考虑:设最后的答案序列为$b$,那么答案其实就是$\sum | b_i - a_i |$.这实际上是什么呢?实际上是数轴上$a_i$和$b_i$之间的距离.既然这样,那么我们同时反转$a$和$b$,这等价于翻转数轴,答案应该是不变的.这说明什么呢?如果我挑一个$a$,将它和$x$同时反转,那么答案不变.这么做后我们可以直接清空所有$a$的最高位,只剩下$x$可能有最高位.

那$x$的最高位一定会让若干$a$往上变成它.注意到最多只会有一个$a$会向上满足$x$的最高位.证明的话同样考虑取反,如果有两个$a$满足$a_i \oplus b_i$和$a_j \oplus b_j$这一位是$1$,我们仍然考虑数轴,有$| not ( b_i ) - a_i | \leq | a_i - b_i |$,这由$a_i \oplus b_i$最高位是$1$导出.因此两个都取反一定不劣.

再考虑,我们会让哪个$a$上去满足呢?自然的想法是取代价最小的那个,因为就算它不是,这里自然地有一个待悔贪心:其它的$a$可以再变成它.

于是就做完了.

Example7(异或粽子)

Example8()

带悔贪心

Example1

给定一个数组,给出若干次操作$[ l , r , k ]$表示可以将$a [ l \cdots r ]$减一进行至多$k$次,要求操作过程中数组时刻非负,求最大能做出的操作次数.

这题的做法是,我们每次遇到一个左端点,就将所有以它为左端点的区间全部操作,并把这些区间按照右端点为关键字扔进堆里.每次遇到一个地方的值变成了负的,就从堆中找右端点最大的区间杀掉.容易发现这样是正确的.

为啥能想到带悔贪心呢?主要是因为我们发现不同的区间会彼此影响,而且有一个限制性的长期条件.因此先不管这个条件,最后再通过调整堆将这个条件调整至合法.

Example2

给定一个序列,每次可以选择相邻的两个数,使其中一个$- 1$,另一个$- 2$,求使得整个序列都小于等于$0$的最小操作次数.

我们明确一下带悔贪心的基本条件:

首先,贪心是需要保证局部最优性的,并且需要保证不考虑全局的前提下,求局部最优解就是全局最优解的一部分.按我的理解,贪心是和dp一样需要有无后效性的,你前面的决策做了就是做了,带悔贪心只能改变后面的决策的形态,而不能改变前面的决策.

不同的操作之间会彼此影响,并且我们在不看全局的状态的前提下,无法第一时间确定当前对后面最优影响的操作是啥.通常情况下,感觉带悔贪心的每个操作会影响的操作是有限的.

感觉能做带悔贪心的好像很多都可以设计一个复杂度更高的dp.不过这个似乎很合理,因为(2)告诉我们它能影响的操作大概率是不多的.

我们看这个题,第一点基本随便编个贪心都可以满足:就是先不断做$( - 2 , - 1 )$,最后不够了再加个$( - 1 , - 2 )$补一下.而第二点呢?显然每个地方的操作只会影响前后两个位置接下来的操作(当然,被影响到的位置有可能继续影响别人).

那么为什么能想到带悔贪心呢?其实只要发现有的时候$( - 1 , - 2 ) + ( - 1 , - 2 )$比$( - 2 , - 1 )$更优秀就自然能引到带悔贪心了.

好,现在我们仍然是做那个看上去就不太对的贪心:先不断做$( - 2 , - 1 )$,最后不够了再加个$( - 1 , - 2 )$补一下.我们通过样例以及其它栗子发现:有的时候$( - 1 , - 2 ) + ( - 1 , - 2 )$比$( - 2 , - 1 )$更优秀,这启发我们:能不能在做后面位置的时候将前面的$( - 2 , - 1 )$变成$( - 1 , - 2 ) + ( - 1 , - 2 )$呢?注意这里我们不能直接换:带悔贪心要求我们不能改变前面操作的状态.因此我们引入一个操作:如果当前前面存在一个$( - 2 , - 1 )$操作,那么我可以在这个位置进行一个$( 0 , - 3 )$操作.显然$( 0 , - 3 ) + ( - 2 , - 1 ) = ( - 1 , - 2 ) + ( - 1 , - 2 )$.我们完成了反悔的操作!

但是,我们直接认为$( - 1 , - 2 )$不可能反悔的原因是:它是一个补位操作,一个位置只有可能进行一次,这玩意不可能能反悔.可现在不一样了,我们的操作序列中有了两个$( - 1 , - 2 ) + ( - 1 , - 2 )$,怎么办呢?你当然可以对着这个操作再观察怎么反悔,但事实上有更高效的思路:我们直接考虑$( - 3 , 0 )$怎么反悔.这个看上去很疑惑:我们为了使$( - 2 , - 1 )$变成$( - 1 , - 2 ) + ( - 1 , - 2 )$而引入了一个新操作,这个新操作在原序列中是不存在的:它甚至有个很奇怪的限制条件:必须在前面存在$( - 2 , - 1 )$的时候才可以发动.那为什么我们可以直接考虑它如何反悔呢?

先看第一个问题:$( - 3 , 0 )$这个技能的发动是有前提条件的:前面必须有$( - 2 , - 1 )$才可以.但你注意我们是在贪心啊,我们很清楚每个地方用了几个$( - 2 , - 1 )$,也很清楚每个地方用了几个$( - 3 , 0 )$.

再看第二个问题:这个新操作为何能反悔呢?其实第一个问题解决这个问题也就解决了,由于贪心,我们知道了巨大多的信息,这个信息量是dp不能比的.因此这个条件如果dp的话看上去需要多记一维,但是贪心完全不用.

我们可以根据类似上面的操作迅速编出它怎么反悔:$( - 3 , 0 ) \rightarrow ( - 1 , - 2 ) + ( - 2 , - 1 ) = ( - 3 , 0 ) + ( 0 , - 3 )$,或者$( - 3 , 0 ) \rightarrow ( - 1 , - 2 ) + ( - 1 , - 2 ) + ( - 1 , - 2 ) = ( - 3 , 0 ) + ( 0 , - 3 ) + ( 0 , - 3 )$.

最后遇到一个点,能用$( 0 , - 3 )$就用$( 0 , - 3 )$,不够用的再补齐.这个原因也很简单:如果我们在这里不用$( - 3 , 0 )$而用其它的代替的话,你会发现无论如何都等价于$( - 3 , 0 )$然后后面再反悔.

再总结一下这个题中包含的带悔贪心:

这个带悔贪心包含若干个操作,这些操作之间可以互相转化,使得在前面进行的一个操作可以和在后面进行的一个操作一起,等价于前面进行了另一个操作.如同最经典的带悔贪心的模型,我们每次进行一个操作后,都会加入若干个可以进行的操作(在这个题中,一开始就在每个位置加入了无穷多的$( - 2 , - 1 )$和$( - 1 , - 2 )$的操作)(写一下代码就会发现,我们其实记录下了每个位置插入了多少个可行的$( - 3 , 0 )$操作).这些操作构成一个封闭的东西,使得反悔任意一个操作的反悔操作本身都可以使用若干操作表示出来.

寻找下界并证明

Example1([EER1]代价)

给你一个长度为$n$的序列$a$,保证$a_1 = a_n = 1$.每次你可以选择一个$i ( 1 < i < n )$将$a_i$删去并付出$a_{ i - 1 } a_i a_{ i + 1 }$的代价.删去$a_i$后序列两端会接起来,求删成两个$1$的最小代价.

首先注意到,如果有一个$1 < i < n$满足$a_i = 1$,那这个点最后删显然更优秀:如果我们把它删了,不仅肯定比最后删它劣(最后删它只需要$1$的代价),还有可能使原本能和它相邻的点这次和一个更大的数相邻了,显然不优秀.因此整个序列被若干个$1$所划分.接下来我们只考虑中间所有数$\geq 2$的情况.

再思考一个事实:当$a , b \geq 2$时,一定有$ab \geq a + b$.而考虑每两个相邻的点一定会被乘起来扔进答案,也就是说答案下界一定是$\sum_{ i = 2 }^{ n - 2 } a_i a_{ i + 1 } + \min_{ i = 2 }^{ n - 1 }{ a_i }$.注意到这个下界是可以构造出来的:找到每一段最小的点然后从左/右挨个删点即可.

Example2(loj3318)

首先考虑:给出一个排列,从原排列换到它的最小步数一定是它的逆序对数.因为我们可以每次找到应当被放到边界的点,然后不断把它换过去.

考虑现在构造$a$数组,每次对于还没选的最大值,显然要扔到尽可能靠后的位置,然后不断递归处理.

Example3

给定一张图,每个点上有一个权值$a_i$,我们每次可以删掉一个点以及其所有连边,代价是所有相邻的点的权值和.求删光图的最小代价.

首先注意到答案一共要更新边数次,不妨考虑边.

一条边可能对答案有两种贡献,也就是与它相邻的两个点的点权.它会对答案贡献后删的那个点的点权.显然所有边取最小值时是一个下界.这个下界是可以构造出来的:我们按照点权从大往小删即可.

Example4([UOJ280]题目难度排序)

先考虑$a_i$互不相同,那可以每次选一个最大的数,满足它加进去后整个集合的中位数$\leq$还没选的数的最小的数.注意到这里一定能构造出合法解,且如果选了另一个数一定更劣.

那如果可能存在$a_i$相同呢,我们先按照大小排序,然后选出一对小于等于所有数的中位数的$( a_i , a_{ i + 1 } )$,然后这么选:$a_i , a_{ i + 1 } , a_n , a_{ i - 1 } , a_{ n - 1 } , a_{ i - 2 } . . .$,一直到左边全部被填完,然后按照互不相同的方法填.

首先这么做一定是合法解,因为中位数会在$a_i$上震荡.其次这么做为什么是最优解呢?我们考虑一开始如果选了另一对大于中位数的相等的数,那一定不合法,因为最后会剩一些小数,会把这些东西震荡到一个更小的中位数.而如果一开始选了一个单点,接下来一定要不断选更大的点,这样比它小的数就没法加进去了.而等左边全部被填完后,由于这个时候中位数已经没有办法保持不变了,所以必定接下来要增大,而中位数不断增大只能按照互不相同的方法填.

Example5([CF1098D]Eels)

首先,我们猜测:我们一开始先让最小的两个互相吃,可能是最优秀的.接下来我们尝试证明这个猜测.

首先,对于一个不危险的操作来说,假设这次操作的两个数是$a$和$b$,其中$2 a < b$.我们尝试判断一下这个操作满足什么条件.这个时候,注意到如果$b$之前吃过别的鱼,假设是$c$和$d$(不妨假设$d \geq c$),有$b = c + d$,由鸽笼原理,发现$d > a$.这意味着:如果$a$都没被操作掉,那么$d$必不可能被操作掉,这也就是说$b$不可能出现.因此$b$在这次操作前一定没有吃过别的鱼.那互相残杀的鱼的重量就都一定小于$b$,且$a$就是所有一开始小于$b$的鱼的和.

我们按照鱼的重量从小到大排序,你会发现一次不危险操作涉及到的鱼一定是一条满足自己大于比自己小的所有鱼的重量和的两倍的鱼,我们称其为大鱼,也就是$w_i > 2 \sum_{ j = 1 }^{ i - 1 } w_j$,我们对此计数就可以完成一次操作.

那么问题又来了,这个东西一定是最小的吗?

我们考虑一个事实:我们要最小化不危险操作的数量,但很明显的一点是:每只大鱼都必须经过一次不危险操作才能变成一只更大的鱼,当然,如果它选择自杀,那么吃掉它的那只鱼会继承它的地位,在不死的情况下仍然要进行至少一次不危险操作才能变成更大的鱼,因此这显然是一个下界.而又可以构造出答案.

那么如何多组询问呢?首先发现大鱼不会很多,最多$\log w$个,我们考虑一下这个两倍的用处,我们按照值域$[ 1 , 1 ] , [ 2 , 2 ] , [ 3 , 4 ] , [ 5 , 8 ] , . . . , [ 2^{ k - 1 } + 1 , 2^k ]$将鱼分成若干组,不难发现大鱼只有可能是每个区间中最小的数字,因为不然,那么这个区间中最小的数字乘以二一定比它自己大.这个东西就很好维护了.

Example6(称球游戏)

给定$n$个球(其中有一个次品球,重量和其它球不一样)和一架天平,求最少通过多少次操作才能找到这个球.

我们通过这个游戏来引入信息论和判定树作为一个构造下界的工具.

首先引入一套语言体系来简化文字:

$S$表示标准球.

$< A , B >$表示称量集合$A$和集合$B$,$< A , B > = 0$表示平衡,$< A , B > = A$表示$A$较重,$< A , B > = B$表示$B$较重.

信息论

如果一个随机变量$x$有$n$种取值,出现概率分别为$p_1 , p_2 , \cdots , p_n$,则其熵为$H ( x ) = f ( p_1 , p_2 , \cdots , p_n ) = \sum{ C p_i \ln \frac{ 1 }{ p_i } }$,$C$为正整数,通常取$1$.(事实上这里的定义与真正的信息论的定义有一定的差别,不过原理是类似的,这里简化了一些.)

定理1:在得到关于随机变量$x$的一个熵为$h$的信息后,$x$的熵会减少$h$.

定理2:当一个随机变量的各种取值概率相等时,它的熵最大.

用信息论估计一下称球游戏的上界,如果我们已知次品轻重,由于一共有$n$个球,每个球等概率成为次品,因此总熵是$\ln n$,每称一次能得到的信息有三种:平衡,左边重,右边重,因此称一次能得到的熵是$\ln 3$,也就是说我们至少要猜$\frac{ \ln n }{ \ln 3 } = \log_3 n$次.如果我们不知道次品的轻重,那么至少要猜$\frac{ \ln 2 n }{ \ln 3 } = \log_3 2 n$次.

这就是称球游戏的信息论下界,接下来我们要做的无非就是证明这个下界能否取得到.

判定树

我们考虑将称量的决策树建立出来,每个叶子节点表示我们得到的答案,每个非叶子节点代表一次称量,每个非叶子节点有三个儿子,分别表示如果称量的结果是左偏/右偏/平衡时,接下来的策略.显然判定树的深度就是最坏情况下称量的次数.

$n$个叶子的树的最小深度是$\lceil \log_3 n \rceil$,这得出和信息论一样的下界估计(信息论的结论好像就是拿哈夫曼树证明的,不太懂).

子问题1(已知次品重量)

不妨假设$f ( n )$表示有$n$个球的最少次数,注意到$f ( 3 ) = 1$.

根据信息论,$f ( n ) \geq \lceil \log_3 n \rceil$,下面证明等号成立:

首先考虑证明$f ( 3^m ) = m$,$m = 1$时已经得证.$m > 1$时,考虑将所有球分成等数量的三份,称量其中两份.由于已知次品重量,这一次就可以找到次品在哪一份中,因此$f ( 3^m ) \leq f ( 3^{ m - 1 } ) + 1$.综合信息论下界$f ( 3^m ) \geq m$,我们不难得出以上结论.至于$n \ne 3^m$的情况,我们类似这个过程按照$n \bmod 3$的值讨论一下即可,于是有$f ( n ) \leq f ( \lceil \frac{ n }{ 3 } \rceil ) + 1$.

子问题2(不知次品轻重,已有一个标准球,需知道次品轻重)

根据信息论下界,$f ( n ) \geq \lceil \log_3 2 n \rceil$.

比起上面的问题,这个问题在于:如果我们称量不平衡,是不知道次品球在两堆中的哪一堆的.但我们思考到:虽然我们不知道在哪一堆,但我们得到了一个额外的信息:如果它在哪一堆,它的重量我们也就知道了.

下面证明引理:

引理

有两堆球,第一堆有$n$个球,第二堆有$m$个,已知其中有一个次品,并且次品如果在第一堆中只可能是重球,在第二堆中只可能是轻球.设此时的称量次数是$g ( n , m )$,则$g ( n , m ) = \lceil \log_3 ( n + m ) \rceil$.

先证明信息论下界,不难发现仍然是$g ( n , m ) = \lceil \log_3 ( n + m ) \rceil$.

首先不难发现,$g ( 1 , 0 ) = g ( 0 , 1 ) = 0 , g ( 1 , 1 ) = g ( 2 , 0 ) = g ( 0 , 2 ) = 1$.

仍然使用数学归纳,假设$n + m < k ( k \geq 3 )$的时候成立,我们接下来证明$n + m = k$的时候仍然成立.

情况1

若$n = 3 p , m = 3 q$,我们将$n$分成等数量的三堆:$A_1 , B_1 , C_1$,将$m$分成等质量的三堆$A_2 , B_2 , C_2$.

接下来称量$\langle A_1 + A_2 , B_1 + B_2 \rangle$.

如果$\langle A_1 + A_2 , B_1 + B_2 \rangle = 0$,那么答案在$C_1 \cup C_2$中,此时有$g ( n , m ) = g ( \frac{ n }{ 3 } , \frac{ m }{ 3 } ) + 1$.

如果$\langle A_1 + A_2 , B_1 + B_2 \rangle = A_1 + A_2$,由于若次品在$A_2$中,那么它不可能是重球,因此次品不可能在$A_2$中,同理不可能在$B_1$中,只可能在$A_1 \cup B_2$中,此时有$g ( n , m ) = g ( \frac{ n }{ 3 } , \frac{ m }{ 3 } ) + 1$.

$\langle A_1 + A_2 , B_1 + B_2 \rangle = B_1 + B_2$,同理.

此时数学归纳成立.

情况2

$n = 3 p + 1 , m = 3 q + 2$.此时我们将第一堆分成$A_1 ( p ) , B_1 ( p ) , C_1 ( p + 1 )$,将第二堆分成$A_2 ( q + 1 ) , B_2 ( q + 1 ) , C_2 ( q )$,然后$\langle A_1 + A_2 , B_1 + B_2 \rangle$,接下来和情况1一样,于是有$g ( n , m ) = \max \{ g ( p , q + 1 ) , g ( p + 1 , q ) \} = \lceil \log_3 \frac{ n + m }{ 3 } \rceil + 1$.

同理,当$n , m \bmod 3$的值是其它组合的时候,也都可以类似操作.引理得证.

由此引理得证.

回到原问题,进行数学归纳,我们继续来讨论$n \bmod 3$的值.

情况1

当$n = 3 p$时,直接分成$A ( p ) , B ( p ) , C ( p )$,然后$\langle A , B \rangle$.如果平衡则接下来需要$f ( p ) = \lceil \log_3 2 p \rceil$次,不然根据引理,需要$\lceil \log_3 ( p + p ) \rceil$次,因此$f ( n ) = \lceil \log_3 2 p \rceil + 1 = \lceil \log_3 6 p \rceil = \lceil \log_3 2 n \rceil$.

情况2

当$n = 3 p + 1$时,一种自然的想法是分成$A ( p + 1 ) , B ( p ) , C ( p )$,但是这种想法是错误的!我们考虑判定树,这种情况下,所有的叶子被分成了$2 p + 2 , 2 p , 2 p$,这显然是不优秀的.正确的做法是分成$A = \{ S , 1 , \cdots p \} , B = \{ p + 1 , \cdots 2 p + 1 \} , C = \{ 2 p + 2 , \cdots 3 p + 1 \}$.由于存在标准球,此时如果$\langle A , B \rangle = A or B$,那么转化成$g ( p , p + 1 ) = \lceil \log_3 ( 2 p + 1 ) \rceil$,不然转化成$f ( p ) = \lceil \log_3 2 p \rceil$.

剩下的情况也都类似,该问题解决.

子问题3(不知次品轻重,无标准球,需知道次品轻重)

考虑在第一次称量后,无论结果如何都会得到一个标准球,因此后面的问题都等价于子问题2,只需考虑第一次操作.再思考一下不难发现,在子问题2中,只有$n \bmod 3 = 1$的时候才会需要用到标准球,因此只有这里需要多一步.拟合一下函数,可以得到该问题$f ( n ) = \lceil \log_3 ( 2 n + 2 ) \rceil$.

子问题4(不知次品轻重,已有一个标准球,无需知道次品轻重)

这个问题复杂一些,而且难以估计下界.但我们可以用一下最优化dp来估计下界.

首先假设有无穷个标准球,我们每次将$a$个球放左边,$b$个球放右边,$a \leq b$,在左边补上$b - a$个标准球.

如果天平不平衡,转化为引理问题(因为此时找到次品是谁必然知道它的轻重),因此需要$\lceil \log_3 ( a + b ) \rceil + 1$步.

如果天平平衡,需要$f ( n - a - b ) + 1$步.

我们有$f ( n ) = \min_{ a , b } \{ \max \{ f ( n - a - b ) , \lceil \log_3 ( a + b ) \rceil \} \} + 1$.

注意到接下来的步数只与$a + b$有关,取$b - a \leq 1$,于是一个标准球已经够用了.

构造方程后手算几项,注意到$f ( n ) = \lceil \log_3 ( 2 n - 1 ) \rceil$.

接下来归纳法就简单了,只需要对于$n \bmod 3$的余数讨论一下,然后再讨论一下$a$的取值即可.

Example7(Ucup 3rd Stage 8 H)

每次可以询问一个区间,交互库返回这个区间中的次大元素所在位置,求$n$所在位置.要求询问次数$\leq \lceil 1 . 5 \log_2 n \rceil$,询问区间总长度$\leq 3 n$.

一个自然的想法是先问一下全局次大值,然后二分,但这样询问区间总长度就会爆掉.

因此考虑设$T ( n )$表示长度为$n$的,已知次大值(并且次大值)的最小次数.我们考虑每次判断一下最大值在哪边,因此把这个区间拆成两半,然后询问一下次大值所在的那一半,这样就可以判断最大值在不在那一半.

那么我们当然有方程$T ( n ) = \min_{ m < n } \{ \max \{ T ( m ) + 1 , T ( n - m ) + 2 \} \}$.

当然有$m_n \leq m_{ n + 1 }$,于是直接dp即可.

Exchange Arguments

模型1

给定$n$个元素$x_1 , . . . , x_n$,以及一个定义域为这些元素的序列,定义域为有序集合的函数$F$.求出对于所有的$n$阶排列$p$,表达式$F ( \{ x_{ p_1 } , x_{ p_2 } , . . . , x_{ p_n } \} )$最小值.

事实上会发现一些NPC问题也可以直接转化为这个模型,但是并无贪心解.我们接下来考虑这个模型内哪些问题是有贪心解的.

Example1(国王游戏)

给定$n$个二元正整数对$( a_i , b_i )$,将它们按照任意顺序排成一列.定义排成一列的代价为每个二元组的$a$乘上序列中这个二元组之后的所有二元组的$b$之和的总和,求最小代价.$n , a_i , b_i \leq 10^6$.

转化为上面的形式,也即:$F ( \{ ( a_1 , b_1 ) , . . . , ( a_n , b_n ) \} ) = \sum_{ 1 \leq i < j \leq k } a_i b_j$.

考虑调整法,令排列$( q_1 , . . . , q_n ) = ( p_1 , . . . , p_{ i - 1 } , p_{ i + 1 } , p_i , p_{ i + 2 } , . . . , p_n )$.则:

因而如果$a_{ p_i } b_{ p_{ i + 1 } } - a_{ p_{ i + 1 } } b_{ p_i } > 0$,则$F ( \{ ( a_{ p_1 } , b_{ p_1 } ) , . . . , ( a_{ p_n } , b_{ p_n } ) \} ) > F ( \{ ( a_{ q_1 } , b_{ q_1 } ) , . . . , ( a_{ q_n } , b_{ q_n } ) \} )$,也就是说$( p_1 , . . . , p_n )$不是最优解.因此只有满足$\forall 1 \leq i < n$,$\cfrac{ a_{ p_i } }{ b_{ p_i } } \leq \cfrac{ a_{ p_{ i + 1 } } }{ b_{ p_{ i + 1 } } }$可能是最优解.

如果一个$p$满足这样的性质,则所有$\cfrac{ a }{ b }$相等的数在排列中一定是连续的一段.而根据式子,这样的排列交换$\cfrac{ a }{ b }$相等的两个位置,是不会使答案改变的.因此直接按照$\cfrac{ a }{ b }$排序即可.

我以前所使用的调整法大概是先构造一个贪心策略,然后证明这个策略改变后一定不优秀或更劣.但是这样对于多峰函数会卡在一个局部最优解上而找不到全局最优解.但是,如果我们说不满足这个条件的一定不是最优解(可以使用调整得到更优解),我们再证明满足这个条件(即调整过程DAG的终止点)的都是最优解,继续做下去,就是很严谨的.

换句话说,我们要用调整法,就一定要证明调整过程中的DAG的零出度点是最优解.

模型通解

设给出的元素的集合为$S$,定义$S$上的一种二元比较关系$\leq$,将所有元素按照比较关系排序.在上一个问题中,不难发现以下性质:

强完全性:$\forall a , b \in S$,$a \leq b \lor b \leq a = 1$.

传递性:$\forall a , b , c \in S$,$a \leq b , b \leq c \Rightarrow a \leq c$.

$\forall a , b \in S$,如果$a \leq b$,则对于任意一个包含$\{ a , b \}$作为子段的元素序列$\{ s_1 , . . . , s_{ k - 1 } , a , b , s_{ k + 2 } , . . . , s_n \}$和$\{ s_1 , . . . , s_{ k - 1 } , b , a , s_{ k + 2 } , . . . , s_n \}$都有:$F ( \{ s_1 , . . . , s_{ k - 1 } , a , b , s_{ k + 2 } , . . . , s_n \} ) \leq F ( \{ s_1 , . . . , s_{ k - 1 } , b , a , s_{ k + 2 } , . . . , s_n \} )$.

问题满足以上性质,那么我们按照这种二元比较关系对元素排序后的答案一定是最优的.原因在于,首先这种操作构成DAG,而定义$\leq$后自然也就定义了$=$,所以DAG的零出度点自然是最优解点.

分析题目时,应该先分析第三条性质得到$\leq$的定义,然后判断是否符合前两条性质.

Example2

给定$n$个包含小写字符的字符串$s_1 , . . . , s_n$,找到一个$n$阶排列$p$,将$s_{ p_1 } , s_{ p_2 } , . . . , s_{ p_n }$顺序拼接得到$S$,使$S$的字典序最小.

令$s \leq t$当且仅当$s + t$的字典序$\leq$t+s

此时我们注意到:$s + t$的字典序小于等于$t + s$的字典序当且仅当$s^{ \infty } \leq t^{ \infty }$.原因是:不妨设$s$的长度$\leq t$的长度.若$s$不是$t$的前缀,那显然只需比较$t$的前缀和$s$的字典序即可,此时上面两个条件等价;若$s$是$t$的前缀,则我们需要比较$t$的前缀和$t$的后缀,注意到$t$的前缀还是$s$,于是需要比较$s$和$t$的后缀.类似可得.

于是这题可以使用后缀数组求任意两个字符串的后缀的最长公共前缀实现.

Example3

有$n$个箱子,第$i$个箱子有重量$w_i$和承载量$v_i$,$( w_i , v_i > 0 )$,将它们堆成一列使得每一个箱子上面的箱子总重量都不大于它的承载量.

考虑最大化$\min_{ i = 1 }^n \{ v_i - \sum_{ j = 1 }^{ i - 1 } w_j \}$,并判断是否$\geq 0$.

我们令$b_i = - ( v_i + w_i ) , a_i = - v_i$,则我们要最大化$\min \{ \sum_{ j = 1 }^{ i - 1 } b_i - \sum_{ j = 1 }^i a_i \}$.

我们接下来将证明所有形如这样的题的通法.

首先,定义$x \leq y$当且仅当$F ( \{ x , y \} ) \leq F ( \{ y , x \} )$,那么对于两个元素$( a_1 , b_1 ) , ( a_2 , b_2 )$,显然$( a_1 , b_1 ) \leq ( a_2 , b_2 )$当且仅当$\min \{ - a_1 , b_1 - a_1 - a_2 \} \geq \min \{ - a_2 , b_2 - a_1 - a_2 \}$.接下来我们证明这样的定义是满足性质的.

对于性质(3),显然成立,因为交换两个相邻位置不会对前面或后面产生影响,而前后对于这两个位置的影响也都可以抵消.

性质(1)显然成立.

再分析一下这个式子,这相当于不等式左边的两个元素都大于等于右边的最小值.我们讨论一下两种情况:

都大于等于第一个元素,则相当于$a_1 \leq a_2 \land b_1 - a_1 \geq 0$.

都大于等于第二个元素,则相当于$b_1 \geq b_2 \land b_2 - a_2 \leq 0$.

可能这里后面和$0$比较没有移项来得简洁.但是,相减的两项是同一个元素的两项,我们显然把它俩放在一类是更优秀的.

注意到需要对$b - a$的符号进行讨论:

若$sgn ( b_1 - a_1 ) > sgn ( b_2 - a_2 )$,则不等式成立.

若$sgn ( b_1 - a_1 ) = sgn ( b_2 - a_2 ) = 1$,则不等式成立当且仅当$a_1 \leq a_2$.

若$sgn ( b_1 - a_1 ) = sgn ( b_2 - a_2 ) = 0$,则不等式成立.

若$sgn ( b_1 - a_1 ) = sgn ( b_2 - a_2 ) = - 1$,则不等式成立当且仅当$b_1 \geq b_2$.

这四条中(2)和(4)的证明是显然的,(3)则是因为此时$b_1 = a_1$,$b_2 = a_2$,两条件必有一真.(1)则是因为此时满足$b_1 - a_1 > b_2 - a_2 \land sgn ( b_1 - a_1 ) \geq 0 \land sgn ( b_2 - a_2 ) \leq 0$.也就有$a_2 - a_1 > b_2 - b_1 \land b_1 \geq a_1 \land b_2 \leq a_2$.怎么着都能成立.

由此发现,对于$sgn ( b - a )$相同的类,内部排序是一定满足传递性的.

但是不同类之间并没有满足传递性,因此我们把排序条件修正为:

模型2

给定$n$个元素$x_1 , . . . , x_n$,以及一个定义域为这些元素的序列,值域为有序集合的函数$F$.求出对于给定整数$k$,所有的$n$阶排列$p$的长度为$k$的子序列,表达式$F ( \{ x_{ p_1 } , x_{ p_2 } , . . . , x_{ p_k } \} )$最小值.

如果$k = n$,则就是模型1.不然,我们考虑先选出一个大小为$k$的子集,然后使用模型1.不难发现,我们最后取出的$\{ x_{ p_1 } , x_{ p_2 } , . . . , x_{ p_k } \}$一定是$n = k$时最优解的一个子序列.这在一些情况下可以降低问题的难度.

Example

有$n$个物品,第$i$个物品有非负费用$c_i$和价值$v_i$,两个人进行如下博弈:

第一个人要么选择一个物品,付出$c_i$的代价;要么选择结束游戏.

第二个人可以选择删除这个物品,这会使博弈回到第一步,且第一个人付出的代价不会消失(这个操作最多可以进行$k$次);也可以选择不操作,此时第一个人获得$v_i$的收益,博弈结束.

第一个人的总收益为收益减去付出的所有代价,第一个人希望最大化收益,第二个人希望最小化收益.$( n \leq 1 . 5 \times 10^5 , k \leq 9 )$

注意到第一个人要么一开始就结束游戏,要么连续选择$k + 1$个,然后收益为$\min_{ i = 1 }^{ k - 1 } \{ v_{ x_i } - \sum_{ j = 1 }^i c_{ x_j } \}$(如果第一个人把一个收益很大的放在最后选,那第二个人可以直接结束游戏防止他选到).注意到这和模型1的Example3是类似的,于是我们可以先排序,然后dp出子序列,复杂度$O ( n \log n + nk )$.

构造

增量构造

Example1

平面上有$n$条直线,将整个平面划分成若干部分.求证:这些部分可以黑白染色使得两个边相邻的部分颜色不相同,并给出构造方案.

考虑数学归纳,现在已经有$n$条直线的答案,求$n + 1$条直线的答案.我们将直线加到这个平面上,并将在这条直线其中一边的部分颜色全部取反.

Example2

给定若干个角度$a_1 , \cdots , a_n \in \{ 90 \degree , 270 \degree \}$,要求构造一个$n$边形(边必须平行于坐标轴),使得其内角依次是$a_1 , \cdots , a_n$.

首先有解条件显然是判定它们的和是否是$180 \degree ( n - 2 )$.

注意到相邻的$90 \degree$和$270 \degree$无非是在原序列上修修改改,这个可以一起合并起来.不断合并就做完了.

Example3(CF1770H)

呃,简单来说就是把边界往里缩,每次找左上和右上的四个点做匹配,然后剩下的缩进去.

原题解的那个图特别清晰.

Example4(ABC232H)

放在这个模块下就好想了,剥一行一列就行.最后可能会剩个边界情况,简单讨论.

找中间状态

常见于操作可逆,想要让$S \rightarrow T$.这个时候可以找一个中间状态$A$,让$S \rightarrow A , T \rightarrow A$.

Example1

坐标系上每个整点有个灯,初始只有$( X , 0 )$亮着,每次把$( x , y )$,$( x , y + 1 )$,$( x + 1 , y )$状态反转,给出终止状态,求初始亮的点的坐标,保证有解且唯一解.

$n \leq 10^5$,坐标的绝对值均$\leq 10^{ 17 }$.

首先我们发现,如果我们上面有若干个亮点,我们一定能把他们全杀了,变到下面,但下面的亮点没办法处理.怎么办呢?

一个想法是,我们将所有的亮点全都推到一条直线$y = - inf$,然后比对.我们注意到$( X , 0 )$向下推的过程类似一个组合数递推的过程,由经典公式$\binom{ S }{ T } \equiv [ T \subseteq S ] \bmod 2$可知,我们取$inf = 2^{ 63 } - 1$即可.然后最后在这条线上一定是有一个区间是$1$,我们需要找到区间左端点,我们选择在直线上随便找到一个$1$,由于$inf$很大,大于$10^{ 17 }$,因此这一步是好找的.然后最后二分+算贡献就可以找到左端点.

这个题有个改版,$n \leq 10^4$,但是初始点可能是$( X , Y )$.

这个题怎么做呢?类似上面的,我们考虑找到两个点$( j , - inf )$和$( k , - inf )$是亮的,并且他们分别是最靠左的和最靠右的,然后我们就能反解出$X$和$Y$.而上述条件满足当且仅当$[ j - X \subseteq Y + inf ]$.

如果我们随便找一个点$( p , - inf )$满足条件,那我们接下来只需要枚举$w$,判断$( p - 2^w , - inf )$是否是亮的,这样就能找到最靠左的,同理可以找到最靠右的.

那么怎么找到这个点呢?我们二分,每次判断一个区间$[ l , r ]$中是否有亮的.这个是难以判断的,但是好判断的是,这个区间中亮的灯的数量是奇数还是偶数.因此我们拿这个判断就行,有奇数就去奇数,两个都是偶数随便去一个.

计算几何

二维计算几何

参考:https://www.luogu.com.cn/blog/command-block/ji-suan-ji-he-suan-fa-hui-zong.

这一部分比较常用,知识点也比较简单,会主要聚焦于写法.

基本函数

eps

1 | const double eps=1e-10 |

浮点数计算存在误差,因此大部分时候不能直接进行大小是否相等的判断,我们需要通过规定精度来减少这种误差.

sign

1 | inline int sign(double x){ |

用于判断一个浮点数是正数还是负数.

myabs

1 | inline double myabs(double x){ |

用来求绝对值.

mysqr

1 | inline double mysqr(double x){ |

用来求平方.

Point/Vector

1 | struct Point{ |

存储基本的点的信息.也可以看作一个二维向量.

向量内积

1 | inline double operator *(const Point &A,const Point &B){ |

也就是$\vec{ a } \cdot \vec{ b } = | \vec{ a } | | \vec{ b } | \cos \theta = x_a x_b + y_a y_b$.也就等于$\vec{ a }$在$b$上的投影与$\vec{ b }$的模长的乘积.

内积可以用来判断夹角:

如果$\vec{ a } \cdot \vec{ b } = 0$,则说明$\vec{ a } \bot \vec{ b }$.

如果$\vec{ a } \cdot \vec{ b } > 0$,则说明$\vec{ a }$和$\vec{ b }$正方向的夹角小于$90 \degree$.

如果$\vec{ a } \cdot \vec{ b } < 0$,则说明$\vec{ a }$和$\vec{ b }$正方向的夹角大于$90 \degree$.

两个向量同时旋转相同角度,其内积结果不变.

向量叉积

1 | double operator ^(const Point &A,const Point &B){ |

也就是$\vec{ a } \times \vec{ b } = x_a y_b - y_a x_b$.也就等于$\vec{ a } , \vec{ b }$两个向量张成的平行四边形(有向)的面积.

叉积可以用来判断方向:

如果$\vec{ a } \times \vec{ b } = 0$,说明二者共线.

如果$\vec{ a } \times \vec{ b } < 0$,说明从$\vec{ a }$到$\vec{ b }$的方向是顺时针.

如果$\vec{ a } \times \vec{ b } > 0$,说明从$\vec{ a }$到$\vec{ b }$的方向是逆时针.

向量旋转

1 | //插入Point内部 |

也就是将这个竖向量乘左乘旋转矩阵$\begin{bmatrix}\cos \theta & - \sin \theta \ \sin \theta & \cos \theta\end{bmatrix}$.

Line

1 | struct Line{ |

用来维护直线/射线/线段的基本信息.

判断线段相交

1 | bool isinter(const Line &L1,const Line &L2){ |

前四行被称为快速排斥实验,后两行被称为跨立实验,也就是相交的两线段,对于其中一个线段而言,它的两个端点必然在另一个线段的两侧.但我们注意到共线线段也会通过跨立实验,因此拿快速排斥实验来判掉这种情况.

注意,线段交点不同于直线交点,两条共线的交点是有可能在端点上的.这个需要特判一下.

当然一般判断线段是否相交可以直接求直线交点,然后判断在不在线段上.

求直线交点

1 | Point inter(const Line &L1,const Line &L2){ |

原理在于,画一下$x_{ L_1 } , x_{ L_2 } , y_{ L_1 } , y_{ L_2 }$围成的四边形,计算面积后用等高不等底计算.注意$ls$和$rs$所代表的面积一正一负(不一定谁是正),因此需要减一下.

点到线的最短距离

1 | inline double disl0(const Point &A,const Line &L){ |

直线好做,直接算垂线段长度,用面积除以底长.

线段用点积判一下夹角即可.

凸多边形面积

利用叉乘,任取平面上一点$O$,则$S = \frac{ 1 }{ 2 } \sum_{ i = 1 }^n \overrightarrow{ OP_i } \times \overrightarrow{ OP_{ i + 1 } }$.证明的话考虑分$O$在内部和$O$在外部两种情况分类讨论.注意此时的$P$必须逆时针排列.

另外有皮克定理:在一个平面直角坐标系内,以整点为顶点的简单多边形(任两边不交叉),它内部整点数为$a$,它的边上(包括顶点)的整点数为$b$,则它的面积$S = a + \frac{ b }{ 2 } - 1$.

基本算法

排序算法

极角排序

定义原点$O$并建立坐标系,所有点按照和$O$所连直线与$x$轴正方向的夹角排序.

极角排序通常使用叉乘来实现,因为叉乘可以快速计算两个向量的方向.但是注意到需要先判断象限,再判断叉乘.

1 | bool cmp(Point A,Point B){//判断A能否在B前面 |

水平序排序

1 | bool cmp(Point A,Point B){ |

也就是$x$相同比$y$,否则比$x$.

二维凸包

定义

包住平面上某个点集的周长最小的简单多边形,一定是凸多边形.

实现

用水平序排序,然后从左往右扫一遍得到上凸壳,从右往左扫一遍得到下凸壳.

用一下以下函数:

1 | inline bool anticlock(const Point &A,const Point &B,const Point &C){ |

前者判断是否$ABC$三点是一个上凸的(注意$ABC$三点横坐标应该不降).后者判断三点共线.

旋转卡壳

定义

定义凸包上的对踵点对,也就是拿两条平行直线卡着凸包转,这两条直线会卡住凸包的两个点,这些点对组成的集合就是对踵点对集合.

实现

逆时针枚举边,然后看对面有什么被卡住了.由于凸包的凸性,在边逆时针转的时候,另一边的对踵点也会逆时针转.只要找到距离这条边所在直线最远的点即可.但这样的点可能有俩.可以简单特判,也可以加上微小随机扰动量使得这种情况可以忽略.

闵可夫斯基和

一般只讨论凸包的闵可夫斯基和.

定义

两个区域$A , B$的闵可夫斯基和定义为$\{ a + b \mid a \in A , b \in B \}$.

实现

事实上,新的区域所形成的凸包,一定是原本$A , B$的凸包的边按照某种顺序连接起来得到的结果.

我们考虑旋转一下$A , B$,使得$B$有一条边成为最右边的直上直下的一条边,然后考虑答案区域的最右边的边,这条边一定是$B$这个边加上$A$的最右边的点.这样这条边必定还在最终的凸包上.就算$A$最右边的是一条边,你也会发现最终的凸包最右边也一定是由$A$的这条边和$B$的这条边拼起来的.

显然,逆时针转一遍整个凸壳,将每条边改为向量(按照逆时针转的方向)然后极角排序,最后顺次链接就是答案.

半平面交

定义

定义半平面为满足$ax + by + c > 0$或$ax + by + c \geq 0$的点对$( x , y )$组成的集合,感性理解就是一条直线的一侧.

实现

首先直线不好描述左右侧,我们把直线改成向量,这样方便描述左右侧.并不妨假设所有的向量所表示的半平面在向量的左侧.如果两条向量方向相同,则取更靠左的那一条,也就是所在直线截距更大的那个,另一个直接删了就是了.当然你不想删可以把那个废物放前面,这样根据下面的操作过程中它会被弹掉.

我们这么实现:按照上面的顺序一个一个插入,维护一个单调队列.如果前两条向量的交点不在当前这条向量的控制范围,不难发现上一条向量是废物,弹掉它.这样做到最后,队首和队尾可能都有一些废物向量,把它们判掉弹掉即可.

三维计算几何

这一部分知识点比较困难,而几乎用不到,因此只讲简单知识点,就当是高中立体几何知识补档!

基本概念

直线

使用直线的方向向量$\vec{ s } = ( n , m , p )$和直线上一点$M_0 = ( x_0 , y_0 , z_0 )$.那么方程显然为:

如果换元,我们还有参数方程:

平面

使用平面上的一点$P_0 ( x_0 , y_0 , z_0 )$和该平面的法向量$\vec{ n }$来表示一个平面,不妨设$\vec{ n } = ( A , B , C )$,则该平面的方程显然为:

如果我们令$D = - ( Ax_0 + By_0 + Cz_)$,那么平面方程为:

夹角

两直线夹角.

直接求方向向量的夹角,然后取正值.

对于方向向量分别是$\vec{ s_1 } = ( n_1 , m_1 , p_1 ) , \vec{ s_2 } = ( n_2 , m_2 , p_2 )$,也就有$\varphi = \arccos ( \frac{ | \vec{ s }_1 \cdot \vec{ s }_2 | }{ | \vec{ s }_1 | | \vec{ s }_2 | } ) \\$.

直线与平面的夹角

同样使用向量,不妨设方向向量$\vec{ s } = ( n , m , p )$,法向量$\vec{ f } = ( a , b , c )$,那么$\varphi = \arcsin ( \frac{ | \vec{ s } \cdot \vec{ f } | }{ | \vec{ s } | | \vec{ f } | } )$.

另外,由上面这个式子,不难得到一些特殊情况下的判定标准:

若直线与平面平行,则$am + bn + cp = 0$.

若直线与平面垂直,则$\frac{ a }{ m } = \frac{ b }{ n } = \frac{ c }{ p }$.注意这里分母可能除以$0$,我们实际上应该是三个形如$a = mt$的参数方程,这里简化了.

交点

联立方程硬解.

基本定理

参考:https://zhuanlan.zhihu.com/p/401766934

三余弦定理(最小角定理)

这个定理说明直线与平面的夹角,是所有包含直线的平面与这个平面形成的夹角中最小的那一个.并且偏移量决定了差距.

三正弦定理(最大角定理)

这个定理说明二面角是另一个平面上的直线与平面的夹角中最大的那个,并且偏移量决定了差距.

组合数学

二项式系数

上升幂和下降幂

定义下降幂$x^{ \underline{ k } } = \prod_{ i = 0 }^{ k - 1 } ( x - i ) = \frac{ x ! }{ ( x - k ) ! }$.

定义上升幂$x^{ \overline{ k } } \prod_{ i = 0 }^{ k - 1 } ( x + i ) = \frac{ ( x + k - 1 ) ! }{ ( x - 1 ) ! }$.

上升幂和下降幂的定义是可以引申到复数域的.

例如我们有加倍公式:$r^{ \underline{ k } } ( r - 0 . 5 )^{ \underline{ k } } = \cfrac{ ( 2 r )^{ \underline{ 2 k } } }{ 2^{ 2 k } } , k \in \mathbb{ N }$.

他们之间存在转换:$x^{ \underline{ n } } = ( - 1 )^n ( - x )^{ \overline{ n } }$.

同时存在大小关系:$x^{ \underline{ n } } \leq x^n \leq x^{ \overline{ n } }$,其中$0 \leq n < x$.

二项式系数的定义

考虑令$\binom{ n }{ m }$表示从一个大小为$n$的子集中选出大小为$m$的子集的方案数.第一次有$n$个选择,第二次有$n - 1$个选择……第m次有$n - m + 1$个选择.而由于可能可以选择重复的,但一个排列被重复选择的次数显然是$m !$,因此显然有$\binom{ n }{ m } = \cfrac{ n^{ \underline{ m } } }{ m ! }$.

如果我们把它的定义拓展到复数域,我们有:

$\binom{ r }{ k } = \begin{cases}\cfrac{ r^{ \underline{ k } } }{ k ! } & k \geq 0 \ 0 & k < 0\end{cases} , r \in \mathbb{ C } , k \in \mathbb{ Z }$.

值得一提的是,如果我们这么定义,本质上其实是把$\binom{ r }{ k }$看作了一个关于$r$的$k$次多项式.

另外根据定义,$r \in \mathbb{ Z } \land r < k$时,该公式给出$0$.

值得一提的是,为了使二项式系数在面对$0$的时候更加简洁,通常直接定义$0 ! = 1 , 0^0 = 1$.

另外不难发现$\binom{ 2 n }{ n }$是所有$\binom{ 2 n }{ k }$中最大的.事实上我们有Wallis公式:$\lim_{ n \rightarrow \infty } \frac{ ( \frac{ 2^{ 2 n } }{ \binom{ 2 n }{ n } } )^2 }{ 2 n + 1 } = \frac{ \pi }{ 2 }$.

基本的二项式恒等式

- 阶乘展开式:$\binom{ n }{ k } = \cfrac{ n ! }{ k ! ( n - k ) ! } , n , k \in \mathbb{ N } , n \geq k \\$.

证明根据定义是显然的.

- 对称恒等式:$\binom{ n }{ k } = \binom{ n }{ n - k } , n \in \mathbb{ N } , k \in \mathbb{ Z } \\$.

根据$( 1 )$,$0 \leq k \leq n$时是显然的.而其他情况两边都会给出$0$,因此也是成立的.

- 吸收恒等式:$\binom{ r }{ k } = \cfrac{ r }{ k } \binom{ r - 1 }{ k - 1 } , k \in \mathbb{ Z } \land k \ne 0 \\$.

证明根据定义是显然的.

- 吸收恒等式的变式:$k \binom{ r }{ k } = r \binom{ r - 1 }{ k - 1 } , k \in \mathbb{ Z } \\$.

根据$( 3 )$,只需要验证$k = 0$的情况即可,也是显然的.

- 相伴恒等式:$( r - k ) \binom{ r }{ k } = r \binom{ r - 1 }{ k } , k \in \mathbb{ Z } \\$.

证明如下:

问题在于:我们在上述描述中并未提到$r$的范围,但是推导过程要求$r \in \mathbb{ N }$.不过,我们已经说明了二项式系数是关于$r$的$k$次多项式,因此只需要有$k + 1$个$r$满足这个公式即可.而根据推导过程显然有无限个$r$满足,因此这个公式对$r \in \mathbb{ C }$也是成立的.

不过事实上,直接用吸收恒等式就可以证明:

- 加法公式:$\binom{ r }{ k } = \binom{ r - 1 }{ k } + \binom{ r - 1 }{ k - 1 } , k \in \mathbb{ Z } \\$.

证明可以使用定义,也可以先用$r \in \mathbb{ N }$的情况给出组合意义,再使用多项式推理法证明.

- $\binom{ r }{ m } \binom{ m }{ k } = \binom{ r }{ k } \binom{ r - k }{ m - k } , n , k \in \mathbb{ Z } \\$.

证明可以使用组合意义和多项式推理法.

- 平行求和法:$\sum_{ k \leq n } \binom{ r + k }{ k } = \binom{ r + n + 1 }{ n } , n \in \mathbb{ N } \\$.

我们不妨考虑不断使用加法公式:

$\binom{ r + n + 1 }{ n } = \binom{ r + n }{ n } + \binom{ r + n }{ n - 1 } = \binom{ r + n }{ n } + \binom{ r + n - 1 }{ n - 1 } + \binom{ r + n - 1 }{ n - 2 } = . . . \\$,最终下标会减成负数,这样后面的项就全都是$0$了.

也可以考虑组合意义:如果$r \in \mathbb{ N }$,那么我们考虑从右到左第一个没有被选上的数,假设它是$r + k + 1$,那么在它右边的数全部选择了,一共是$n - k$个数,而还需要在左边的$r + k$中选择$k$个数.

- 上指标求和法:$\sum_{ 0 \leq k \leq n } \binom{ k }{ m } = \binom{ n + 1 }{ m + 1 } , n , m \in \mathbb{ N } \\$.

可以组合意义解释:我们不妨假设选的最大数是$k + 1$,接下来就还需要在$[ 1 , k ]$中选择$m$个.

如果我们将这个公式两边同时乘以$m !$,我们可以得到公式:$\sum_{ 0 \leq k \leq n } k^{ \underline{ m } } = \cfrac{ ( n + 1 )^{ \underline{ m + 1 } } }{ m + 1 } , n , m \in \mathbb{ N } \\$,这也就是有限微积分的公式中的一个.

- 二项式定理:$( x + y )^r = \sum_{ k } \binom{ r }{ k } x^k y^{ r - k } , r \in \mathbb{ N } \\$.

可以使用组合意义证明.

二项式定理有一些有用的特殊情况:

在二项式定理中令$x = y = 1$即可证明.

在二项式定理中令$x = - 1 , y = 1$即可证明,值得一提的是,当$n = 0$的时候这个式子给出$1$,并在其他情况下给出$0$,这个式子是二项式反演的基础.

- 三项式定理:$( x + y + z )^n = \sum_{ 0 \leq a , b , c \leq n } [ a + b + c = n ] \cfrac{ n ! }{ a ! b ! c ! } x^a y^b z^c , n \in \mathbb{ N } \\$.

证明与二项式定理类似.值得一提的是,$\cfrac{ n ! }{ a ! b ! c ! } = \binom{ n }{ b + c } \binom{ b + c }{ c }$.

- 多项式定理:$( \sum_{ i = 1 }^m x_i )^n = \sum_{ \forall i \in [ 1 , m ] , 0 \leq a_i \leq n } [ \sum_{ i = 1 }^m a_i = n ] \cfrac{ n ! }{ \prod_{ i = 1 }^m a_i ! } \prod_{ i = 1 }^m x_i^{ a_i } , n \in \mathbb{ N } \\$.

证明与二项式定理类似.

- 范德蒙德卷积:$\sum_{ k } \binom{ r }{ m + k } \binom{ s }{ n - k } = \binom{ r + s }{ n + m } , n , m \in \mathbb{ Z } \\$.

证明可以使用组合意义和多项式推理法.

另外,这个式子可以直接使用生成函数证明.

- 范德蒙德卷积的变式:$\sum_{ k } \binom{ l }{ m + k } \binom{ s }{ n + k } = \binom{ l + s }{ l - m + n } , l \in \mathbb{ N } , n , m \in \mathbb{ Z } \\$.

有$\binom{ l }{ m + k } = \binom{ l }{ l - m - k }$,然后运用范德蒙德卷积即可得到答案.

- 上指标反转公式:$\binom{ r }{ k } = ( - 1 )^k \binom{ k - r - 1 }{ k } \\$.

根据定义显然.

扩展的二项式恒等式(整数范围内)

- $\sum_{ k \leq m } \binom{ r }{ k } ( - 1 )^k = ( - 1 )^m \binom{ r - 1 }{ m } , m \in \mathbb{ Z } \\$.

证明如下:

- $\sum_{ - q \leq k \leq l } \binom{ l - k }{ m } \binom{ q + k }{ n } = \binom{ l + q + 1 }{ m + n + 1 } , n , m \in \mathbb{ N } , l + q \geq 0 \\$.

可以组合意义与多项式推理法证明.

- $\sum_{ k } \binom{ a + b }{ a + k } \binom{ a + b }{ b + k } ( - 1 )^k = \binom{ a + b }{ a } , a , b \in \mathbb{ N } \\$.

可以数学归纳证明.

- $\sum_{ k = 0 }^m \cfrac{ \binom{ m }{ k } }{ \binom{ n }{ k } } = \cfrac{ n + 1 }{ n + 1 - m } , n , m \in \mathbb{ N } , n \geq m \\$.

我们有$\binom{ n }{ m } \binom{ m }{ k } = \binom{ n }{ k } \binom{ n - k }{ m - k } \\$,两边同时除以$\binom{ n }{ m } \binom{ n - k }{ m - k } \\$,于是我们得到了$\cfrac{ \binom{ m }{ k } }{ \binom{ n }{ k } } = \cfrac{ \binom{ n - k }{ m - k } }{ \binom{ n }{ m } } \\$.

有:

- $( - 1 )^m \binom{ - n - 1 }{ m } = ( - 1 )^n \binom{ - m - 1 }{ n } , n , m \in \mathbb{ N } \\$.

根据上指标反转公式,这个公式两边都等于$\binom{ n + m }{ m } \\$.

- $\sum_{ k \leq m } \binom{ r }{ k } ( \cfrac{ r }{ 2 } - k ) = \cfrac{ m + 1 }{ 2 } \binom{ r }{ m + 1 } , m \in \mathbb{ Z } \\$.

可以使用归纳法证明这个公式.

- $\sum_{ k \leq m } \binom{ m + r }{ k } x^k y^{ m - k } = \sum_{ k \leq m } \binom{ - r }{ k } ( - x )^k ( x + y )^{ m - k } , m \in \mathbb{ Z } \\$.

不妨令左边的值为$S_m$,我们有:

左右两边满足相同递归式,通过数学归纳法不难证明二者相等.

- $\sum_{ k \leq m } \binom{ m + k }{ k } 2^{ - k } = 2^m , m \in \mathbb{ N } \\$.

考虑$( 7 )$,将$x = y = 1 , r = m + 1$带入,得到:

- $\sum_{ k } \binom{ l }{ m + k } \binom{ s + k }{ n } ( - 1 )^k = ( - 1 )^{ l + m } \binom{ s - m }{ n - l } , l \in \mathbb{ N } , n , m \in \mathbb{ Z } \\$.

可以数学归纳证明.

- $\sum_{ k \leq l } \binom{ l - k }{ m } \binom{ s }{ k - n } ( - 1 )^k = ( - 1 )^{ l + m } \binom{ s - m - 1 }{ l - n - m } , l , n , m \in \mathbb{ N } \\$.

可以数学归纳证明.

拓展的二项式恒等式(实数范围内)

- $\binom{ r }{ k } \binom{ r - \cfrac{ 1 }{ 2 } }{ k } = \cfrac{ \binom{ 2 r }{ 2 k } \binom{ 2 k }{ k } }{ 2^{ 2 k } } , k \in \mathbb{ Z } \\$.

将加倍公式两边同时除以$k !^2$即可得到这个公式.

- $\binom{ n - \cfrac{ 1 }{ 2 } }{ n } = \cfrac{ \binom{ 2 n }{ n } }{ 2^{ 2 n } } , n \in \mathbb{ Z } \\$.

将$( 1 )$中令$r = k = n$即可得到这个公式.

- $\binom{ - \cfrac{ 1 }{ 2 } }{ n } = ( \cfrac{ - 1 }{ 4 } )^n \binom{ 2 n }{ n } , n \in \mathbb{ Z } \\$.

即$( 2 )$的变形.

- $\sum_{ k } \binom{ n }{ 2 k } \binom{ 2 k }{ k } 2^{ - 2 k } = \binom{ n - \cfrac{ 1 }{ 2 } }{ \lfloor \cfrac{ n }{ 2 } \rfloor } , n \in \mathbb{ N } \\$

首先根据$( 1 )$,左边$= \sum_{ k } \binom{ \cfrac{ n }{ 2 } }{ k } \binom{ \cfrac{ n - 1 }{ 2 } }{ k } \\$,而考虑到$\cfrac{ n }{ 2 }$和$\cfrac{ n - 1 }{ 2 }$必有一个是自然数,因此可以直接用范德蒙德卷积的变形.

- $\sum_{ k } \binom{ - \cfrac{ 1 }{ 2 } }{ k } \binom{ - \cfrac{ 1 }{ 2 } }{ n - k } = ( - 1 )^n , n \in \mathbb{ N } \\$.

直接使用范德蒙德卷积即可证明.

- $\sum_{ k } \binom{ 2 k }{ k } \binom{ 2 n - 2 k }{ n - k } = 4^n , n \in \mathbb{ N } \\$.

由$( 5 )$和$( 3 )$不难推出.

- $\sum_{ k } \binom{ n }{ k } \cfrac{ ( - 1 )^k }{ x + k } = x^{ - 1 } \binom{ x + n }{ n }^{ - 1 } , x \notin \{ 0 , - 1 , . . . , - n \} \\$.

令$f ( x ) = ( x - 1 )^{ \underline{ - 1 } }$,直接做高阶差分即可得到这个式子.

- $\sum_{ k = 0 }^n \binom{ r }{ k } \binom{ r }{ n - k } ( - 1 )^k = [ n is \mathrm{ even } ] ( - 1 )^{ \cfrac{ n }{ 2 } } \binom{ r }{ \cfrac{ n }{ 2 } } \\$.

首先不难发现,$( 1 - z )^r = \sum_{ k \geq 0 } ( - 1 )^k \binom{ r }{ k } \\$.

考虑$( 1 - z )^r ( 1 + z )^r = ( 1 - z^2 )^r$.

我们有$[ z^n ] ( 1 - z )^r ( 1 + z )^r = [ z^n ] ( 1 - z^2 )^r$,不难发现即上式.

卡特兰数

卡特兰数$f_n$表示:长度为$2 n$的合法括号序列个数.

卡特兰数的前几项为$1 , 1 , 2 , 5 , 14 , 42 , 132 \cdots$.

接下来,我们通过这个定义来证明以下其他定义方式.

递归定义:$f_n = \sum_{ i = 0 }^{ n - 1 } f_i f_{ n - 1 - i }$.

不妨考虑枚举一个括号序列的第一个断点,则该括号序列应形如$( A ) B$.

考虑将其删成$A$和$B$,则$A$一定合法,因为若$A$不合法,那么这里一定不是第一个断点.

通项公式:$f_n = \frac{ 1 }{ n + 1 } C_{ 2 n }^n = C_{ 2 n }^n - C_{ 2 n }^{ n - 1 }$.

考虑平面直角坐标系,我们将’(‘认为是向右上走一单位长度,将’)’认为是向右下走一单位长度.

那么卡特兰数就相当于从$( 0 , 0 )$走到$( 2 n , 0 )$不经过第四象限的方案数.

考虑反射容斥,如果只是走到$( 2 n , 0 )$的方案数是$C_{ 2 n }^n$.

而如果到达第四象限,说明在这条这线上存在一个点$( x , - 1 )$.

考虑将$x$以后的折线以直线$y = - 1$为对称轴反转,那么终点到了$( 2 n , - 2 )$.

不难发现,任意从$( 0 , 0 )$走到$( 2 n , - 2 )$的方案一定唯一对应了一种从$( 0 , 0 )$走到$( 2 n , 0 )$的不合法方案.因为从$( 0 , 0 )$走到$( 2 n , - 2 )$一定会经过直线$y = - 1$,将后半部分对称后就是其对应方案.而从$( 0 , 0 )$走到$( 2 n , - 2 )$的方案数为$C_{ 2 n }^{ n - 1 }$.

因而$f_n = C_{ 2 n }^n - C_{ 2 n }^{ n - 1 } \\$.

而$C_{ 2 n }^n - C_{ 2 n }^{ n - 1 } = \frac{ ( 2 n ) ! }{ n ! n ! } - \frac{ ( 2 n ) ! }{ ( n - 1 ) ! ( n + 1 ) ! } = \frac{ ( 2 n ) ! }{ n ! ( n + 1 ) ! } = \frac{ C_{ 2 n }^n }{ n + 1 } \\$.

递推定义:$f_n = \frac{ 4 n - 2 }{ n + 1 } f_{ n - 1 } \\$.

使用一下上一步的通项公式:

f_n=\frac{(2n)!}{n!(n+1)!}\\

f_{n-1}=\frac{(2n-2)!}{(n-1)!(n)!}

\end{cases}\\

不难发现$f_n = \frac{ ( 2 n - 1 ) ( 2 n ) }{ n ( n + 1 ) } f_{ n - 1 } \\$.整理,得到$f_n = \frac{ 4 n - 2 }{ n + 1 } f_{ n - 1 } \\$.

换个记号,设$C_n$为卡特兰数的第$n$项,卡特兰数有一个著名的结论是$k$次卷积:

我们可以这么理解它:它指的是一个长度为$n + k - 1$的括号序列,前$k - 1$个必须是左括号的方案数.为啥呢?因为这样这个括号序列必须写成$( ( ( A ) B ) C ) D$之类的形式,等价于卷积.

那么证明就很简单了,类似反射容斥,有:

Example([HNOI2009]有趣的数列)

首先,如果没有第三条限制,那显然奇数位置和偶数位置互不影响,直接随便选,答案就是$\binom{ 2 n }{ n }$.

而有了限制呢,我们还是想随便选然后顺序排起来,但是这次不能排列的时候使奇数位置大于偶数位置,可以发现这就是括号序列需要满足的条件,于是答案就是卡特兰数.

至于处理,这题因为模数不是质数,需要做质因数分解来维护除法.

Example2([23省选10连测day7]b)

给定$x , n$,对$y \in [ 1 , n ]$,固定$p_x = y$做笛卡尔树的形态计数.$n \leq 5 \times 10^5$.

由于是对树的形态计数,其实根本就不在乎每个点具体的取值,只要这个取值有解就行.事实上,容易发现$a_x = y$只要满足:

$x$节点的祖先数量不超过$y - 1$个(深度小于等于$y$).

$x$节点的子树大小不超过$n - y + 1$.

发现合法不太好记,经典补集转化,然后两个不合法情况无关,分别算.

我们考虑直接算出$f_p$表示$x$的深度为$p$的答案,$g_p$表示$x$的子树大小为$p$的答案,然后就可以完成这个题.

这两部分怎么算呢?

先看深度:$x$的祖先有两种:一种在序列中在$x$的左边,一种在$x$的右边.我们设前者为$0 = l_0 < l_1 < l_2 < \cdots l_p < l_{ p + 1 } = x$,设后者为$n + 1 = r_0 > r_1 > r_2 > \cdots > r_{ q } > r_{ q + 1 } = x$.这么分类有什么用呢?我们考虑$( l_{ i - 1 } , l_{ i } )$这一段数能放在哪里,它只能是$l_{ i }$的左儿子,独立于整棵树,因此这一段的答案就是$C_{ l_i - l_{ i - 1 } - 1 }$.

记:

注意到这等价于卡特兰数的$k$次卷积,有:

此时的答案自然是$f_{ p + q + 1 } = L_p R_q \binom{ p + q }{ q }$,做卷积.

儿子怎么算呢?二叉搜索树有一个经典性质:确定根后每个点插在哪里是固定的.也就是说我们把$x$的子树从原树中删去,然后插入$x$一定会插回原位置,这是一个双射.而子树内随便做,设左子树大小为$p$,右子树大小为$q$,我们有$g_{ p + q + 1 } = C_p C_q C_{ n - ( p + q + 1 ) } = C_{ n - 1 }^{ ( 3 ) }$,同样是简单的卷积.

二项式系数的处理

通过恒等式变形求解

Example1

求$\sum_{ k = 0 }^n k \binom{ m - k - 1 }{ m - n - 1 } , n , m \in \mathbb{ N } \land m > n \\$.

这个式子乘了个系数$k$导致很难处理,一个自然的想法是使用吸收恒等式将$k$消去,然后对后面的式子使用上指标求和.

于是:

不妨令$S_m = \sum_{ k = 0 }^m \binom{ m - k }{ m - n } \\$,不难发现我们有:

于是原式$= mS_{ m - 1 } - ( m - n ) S_m = \cfrac{ n }{ m - n + 1 } \binom{ m }{ m - n } \\$.

不过事实上,我们有另一种方式来处理这个等式,我们直接将$k = \binom{ k }{ 1 }$带入:

Example2

求$\sum_{ k } k \binom{ n }{ k } \binom{ s }{ k } , n \in \mathbb{ N } \\$.

第一反应仍然是使用吸收恒等式,但是注意到$n$和$s$的范围不一样,由于吸收恒等式的范围很松,因此应选择一个范围更松的数吸收,这样才能保证另一个数范围的特殊性,于是有:

Example3

求$\sum_{ 0 \leq k } \binom{ n + k }{ 2 k } \binom{ 2 k }{ k } \cfrac{ ( - 1 )^k }{ k + 1 } , n \in \mathbb{ N } \\$.

我们有:

Example4

求$\sum_{ k \geq 0 } \binom{ n + k }{ m + 2 k } \binom{ 2 k }{ k } \cfrac{ ( - 1 )^k }{ k + 1 } , n , m \in \mathbb{ N_+ } \\$.

考虑恒等式扩展的二项式恒等式(整数范围内)的$( 1 )$,我们有:

注意到如果$j + 1 - n \geq 0$,则$\binom{ n + k - 1 - j }{ 2 k } \\$应为$0$.所以有:

Example5

求$\sum_{ k = 0 }^n ( C_n^k )^2$.

转化为递归式/和式求解

Example1

求$Q_n = \sum_{ k \leq 2^n } \binom{ 2^n - k }{ k } ( - 1 )^k , n \in \mathbb{ N } \\$.

如果要转化为递归式的话,我们所掌握的只有加法恒等式,但加法恒等式只给出了杨辉三角中相邻两行的关系.但由于$Q_n$的式子中实际上只与$2^n$有关,我们不妨令$R_n = \sum_{ k \leq n } \binom{ n - k }{ k } ( - 1 )^k \\$,显然有$Q_n = R_{ 2^n }$.

而我们有:

也即$R_n$具有周期性,不难计算前几项答案,最后有$Q_n \begin{cases}1 & n = 0 \ 0 & n is \mathrm{ odd } \ - 1 & n > 0 \land n is \mathrm{ even }\end{cases}$.

Example2

求$( \sum^{ + \infty }_{ i = 0 } C^{ ik + r }_{ nk } ) \mod p$.

考虑设$f ( n , r ) = \sum^{ + \infty }_{ i = 0 } C^{ ik + r }_{ nk } \\$,则有:

整理上式,得到:$f ( n , r ) = \sum_{ j = 0 }^k C_k^j f ( n - 1 , r - j ) \\$.

于是我们得到了关于$f$的转移方程,可以矩阵加速.

利用微积分求解

Example

求$\sum_{ k = 1 }^n k^2 C_n^k$.

取$x = 1$,则原式$= n ( n + 1 ) 2^{ n - 2 }$.

转化为二维平面

Example1

多次询问给定$k , r$,$\sum k \leq 2 n , r < 2 n - k$,求$\sum_{ i = 0 }^{ r } \frac{ 1 }{ 2^i } \binom{ i }{ n - k }$,.

我们把模型抽象成:在二维平面上,从$( 0 , 0 )$随机游走到$( n - k + 1 , r - n + k )$正下方(包含这个点)的概率,容易发现此时向右走了$n - k$步,总共走了$\leq r$步,然后再向右走一步保证第一次走到了$( n - k + 1 , r - n + k )$下方.

因为是概率,所以当我们已经确定这个事会发生的时候可以多走几步,不难发现这里的概率等价于走到$x + y = r + 1$这条直线时横坐标$\geq n - k + 1$的概率.枚举一下总共向上走了几步,就得到$\frac{ 1 }{ 2^{ r } } \sum_{ j = 0 }^{ r - n + k } \binom{ r + 1 }{ j }$,注意这里是$\frac{ 1 }{ 2^r }$,因为从一开始钦定了一步,因此映射过来需要多乘个$\frac{ 1 }{ 2 }$,反映射就要乘个$2$.但是这个式子还是做不了,因为$r$并不满足$\sum r \leq 2 n$.我们需要另辟蹊径.

做一下补集转化转化成走到上方的概率,这个概率就等价于$1 - \frac{ 1 }{ 2^{ r } } \sum_{ i = 0 }^{ n - k } \binom{ r + 1 }{ i }$.我们考虑暴力预处理出$f_r = \sum_{ i = 0 }^{ n } \binom{ r }{ i }$,每次删掉一个后缀的组合数就行.现在的问题在于$f$怎么做.

直接拆组合数,我们有:

Lucas定理

若$p$是质数,则$C_n^m \mod p = C_{ n \mod p }^{ m \mod p } \times C_{ \lfloor \frac{ n }{ p } \rfloor }^{ \lfloor \frac{ m }{ p } \rfloor } \mod p \\$.

或者说,将$n$和$m$在$p$进制下分解,再逐位求组合数并相乘.

证明:

首先,若$i \ne 0$且$i \ne p$,$C_{ p }^i \equiv \frac{ p }{ i } C_{ p - 1 }^{ i - 1 } \equiv 0 ( \mod p ) \\$.

而根据二项式定理,$( 1 + x )^p \equiv \sum_{ i = 0 }^p C_{ p }^i x^i = 1 + x^p ( \mod p ) \\$.

令$n = k_1 p + b_1$,$m = k_2 p + b_2$,则$( 1 + x )^n = ( 1 + x )^{ k_1 p } ( 1 + x )^{ b_1 } \\$.

而$( 1 + x )^{ k_1 p } \equiv ( 1 + x^p )^{ k_1 } ( \mod p ) \\$,有$( 1 + x )^n \equiv ( 1 + x^p )^{ k_1 } ( 1 + x )^{ b_1 } \\$.

根据二项式定理,$C_n^m \bmod p$即$x^m$项的系数.

我们可以得出,$C_n^m x^m \equiv C_{ k_1 }^{ k_2 } x^{ k_2 p } C_{ b 1 }^{ b_2 } x^{ b_2 } \pmod{ p } \\$,那么有$C_a^b \equiv C_{ k_1 }^{ k_2 } C_{ b_1 }^{ b_2 } \pmod{ p } \\$.

另外,Lucas定理有一个很重要的推论是:

Example1([CF1770F]Koxia and Sequence)

首先观察样例并思考,可以发现当$n$为偶数时,显然翻转整个序列就可以一一对应(除非翻转后与本身相同,但这种情况下异或值也是$0$),所以异或值为$0$.不然,我们可以翻转$a [ 2 . . . n ]$,得出答案应该是所有$a_1$的异或和.

问题在于接下来怎么做,我们考虑把按位或的那个东西容斥掉.现在问题转化为:对于所有$y ‘ \subseteq y$,求出满足$a_i \subseteq y ‘ , \sum a_i = x$时,$a_1$异或和.接下来怎么做呢?我们考虑拆位,若$2^k \subseteq y ‘$,假设$a_1$的第$k$位是$1$,然后讨论此时它对答案是否会产生贡献.

我们不难发现,第$k$位贡献是:

这个东西看上去没办法做,但我们突然想到个事:Lucas定理的推论:$[ x \subseteq y ] \equiv \binom{ y }{ x } \pmod{ 2 }$.

所以原式化简为:

然后呢?不难发现后面那一串是范德蒙德卷积的形式,就可以写成:

扩展Lucas定理

令$p = \prod p_i^{ e_i }$,那我们只要对于每个$i$求出$C_n^m \mod p_i^{ e_i }$,然后使用中国剩余定理合并即可.

那现在问题转化为要求$C_n^m \mod p^k$,其中$p \in \mathrm{ prime }$.

原式$= \frac{ n ! }{ m ! ( n - m ) ! } \mod p^k = \frac{ \frac{ n ! }{ p^x } }{ \frac{ m ! }{ p^y } \frac{ ( n - m ) ! }{ p^z } } p^{ x - y - z } \mod p^k \\$.

现在问题转化为求$\frac{ n ! }{ p^x } \mod p^k 以 及 p^x \\$.

注意到:

递归求解即可.

ps:

这样摆式子可能非常难以理解,我们考虑将$[ 1 , n ]$的所有数全部排成一个宽为$p^k$的矩阵.

那右边第一项就是把那些$p$的倍数的列拿出来,第二项是那些填满的行,第三项是最后没填满的一行.

斯特林数

第一类斯特林数

$n \brack k \\$:长度为$n$的排列划分成$k$个轮换的方案数.

考虑现在已经将$n - 1$个数分成了若干轮换,现在新加入第$n$个数.这个数要么和其他的数一起组成轮换,要么自己形成自环.

而由于它可以插入前面轮换的任意位置,显然$\left [ \begin{array}{ c } n \ k\end{array} \right ] = ( n - 1 ) \left [ \begin{array}{ c } n - 1 \ k\end{array} \right ] + \left [ \begin{array}{ c } n - 1 \ k - 1\end{array} \right ] \\$.

特别地,我们定义$\left [ \begin{array}{ c } 0 \ k\end{array} \right ] = [ k = 0 ] \\$.

由于所有的排列都由若干置换组成,因此我们有:$\sum_{ k = 0 }^n \left [ \begin{array}{ c } n \ k\end{array} \right ] = n !$.

第二类斯特林数

$\left \{ \begin{array}{ c } n \ k\end{array} \right \}$:将$n$个本质不同的物品划分成k个非空集合的方案数.

考虑现在已经放好$n - 1$个物品,正要放入第$n$个物品.那么这个物品要么单独放在一起,要么和其他物品放在一起.显然$\left \{ \begin{array}{ c } n \ k\end{array} \right \} = k \left \{ \begin{array}{ c } n - 1 \ k\end{array} \right \} + \left \{ \begin{array}{ c } n - 1 \ k - 1\end{array} \right \} \\$.

特别地,我们定义$\left \{ \begin{array}{ c } 0 \ k\end{array} \right \} = [ k = 0 ] \\$.

斯特林数的扩展

如果我们让斯特林数的定义式扩展到整数域,我们可以发现一个性质:${ n \brack m } ={ - m \brace - n } \\$.

基本斯特林恒等式

- $x^n = \sum_{ k = 0 }^n \left \{ \begin{array}{ c } n \ k\end{array} \right \} x^{ \underline{ k } } = \sum_{ k = 0 }^n \left \{ \begin{array}{ c } n \ k\end{array} \right \} ( - 1 )^{ n - k } x^{ \overline{ k } } \\$.

证明:先考虑前半段,不妨使用数学归纳.若$x^{ n - 1 } = \sum_{ k = 0 }^{ n - 1 } \left \{ \begin{array}{ c } n - 1 \ k\end{array} \right \} x^{ \underline{ k } } \\$,我们要证

\\

考虑$( x - k ) x^{ \underline{ k } } = x^{ \underline{ k + 1 } }$,所以$x \cdot x^{ \underline{ k } } = x^{ \underline{ k + 1 } } + kx^{ \underline{ k } } \\$.那么左边即:

至于后半段,由于$x^{ \underline{ n } } = ( - 1 )^n ( - x )^{ \overline{ n } } \\$,所以$x^n = \sum_{ k = 0 }^n \left \{ \begin{array}{ c } n \ k\end{array} \right \} ( - 1 )^k ( - x )^{ \overline{ k } } \\$.

不妨用$x$来代替$- x$,我们有:

$x^{ \overline{ n } } = \sum_{ k = 0 }^n \left [ \begin{array}{ c } n \ k\end{array} \right ] x^k \\$.

$x^{ \underline{ n } } = \sum_{ k = 0 }^n \left [ \begin{array}{ c } n \ k\end{array} \right ] ( - 1 )^{ n - k } x^k \\$.

证明:

先考虑前者,由于$( x + n - 1 ) x^k = x^{ k + 1 } + ( n - 1 ) x^k \\$,所以类似于(1)前半段的推导即可得到,后者同样可以使用下降幂和上升幂的转化来得到.

- 反转公式:$\sum_{ k = 0 }^n \left [ \begin{array}{ c } n \ k\end{array} \right ] \left \{ \begin{array}{ c } k \ m\end{array} \right \} ( - 1 )^{ n - k } = \sum_{ k = 0 }^n \left \{ \begin{array}{ c } n \ k\end{array} \right \} \left [ \begin{array}{ c } k \ m\end{array} \right ] ( - 1 )^{ n - k } = [ m = n ] \\$.

证明:

考虑先证明后半部分,将(3)带入(1),得到$x^n = \sum_{ k = 0 }^n \left \{ \begin{array}{ c } n \ k\end{array} \right \} x^{ \underline{ k } } = \sum_{ k = 0 }^n \sum_{ m = 0 }^k \left \{ \begin{array}{ c } n \ k\end{array} \right \} \left [ \begin{array}{ c } k \ m\end{array} \right ] ( - 1 )^{ n - k } x^m \\$.

由于这对任意$x$都成立,因此右边除了$x^n$以外的项系数均为$0$,而$x^n$的系数为$1$.前半部分是同理的.这个公式是斯特林反演的基础.

$\left \{ \begin{array}{ c } n + 1 \ m + 1\end{array} \right \} = \sum_{ k = m }^n \left ( \begin{array}{ c } n \ k\end{array} \right ) \left \{ \begin{array}{ c } k \ m\end{array} \right \} \\$.

$\left [ \begin{array}{ c } n + 1 \ m + 1\end{array} \right ] = \sum_{ k = m }^n \left ( \begin{array}{ c } n \ k\end{array} \right ) \left [ \begin{array}{ c } k \ m\end{array} \right ] \\$.

证明:对于前者,考虑组合意义,将$n + 1$个分为$m + 1$组,也就是先找一部分分成$m$组,再把剩下的分到一组.对于后者,也可以同样考虑组合意义.

补充斯特林恒等式

$\left \{ \begin{array}{ c } n \ m\end{array} \right \} = \sum_{ k = m }^n \left ( \begin{array}{ c } n \ k\end{array} \right ) \left \{ \begin{array}{ c } k + 1 \ m + 1\end{array} \right \} ( - 1 )^{ n - k } \\$.

$\left [ \begin{array}{ c } n \ m\end{array} \right ] = \sum_{ k = m }^n \left ( \begin{array}{ c } n \ k\end{array} \right ) \left [ \begin{array}{ c } k + 1 \ m + 1\end{array} \right ] ( - 1 )^{ n - k } \\$.

证明:由(5)(6),根据二项式反演可知.

- $m ! \left \{ \begin{array}{ c } n \ m\end{array} \right \} = \sum_{ k = 0 }^m C_m^k k^n ( - 1 )^{ m - k } \\$.

证明:首先有$m^n = \sum_{ k = 0 }^m m^{ \underline{ k } } \left \{ \begin{array}{ c } m \ k\end{array} \right \} = \sum_{ k = 0 }^m k ! C_m^k \left \{ \begin{array}{ c } m \ k\end{array} \right \} \\$,对这个式子进行二项式反演即可.

- $\left \{ \begin{array}{ c } n + 1 \ m + 1\end{array} \right \} = \sum_{ k = 0 }^n \left \{ \begin{array}{ c } k \ m\end{array} \right \} ( m + 1 )^{ n - k } \\$.

证明:

考虑组合意义,相当于先把前$k$个分为$m$组,把第$k + 1$个数放到第$m + 1$组.然后剩下$( n + 1 ) - ( k + 1 ) = n - k$个随便放.相当于我们按照每组所放的数的最小值区分每组.由于这么做,第$m + 1$组(最小值最大的那组)在$k$不同的时候最小值是不同的,因此一定不重不漏.

- $\left [ \begin{array}{ c } n + 1 \ m + 1\end{array} \right ] = \sum_{ k = 0 }^n \left [ \begin{array}{ c } k \ m\end{array} \right ] C_{ n }^k ( n - k ) ! = n ! \sum_{ k = 0 }^n \frac{ \left [ \begin{array}{ c } k \ m\end{array} \right ] }{ k ! } \\$.

证明:

先考虑前半部分,首先如果$n > 0$,我们有$\left [ \begin{array}{ c } n \ 1\end{array} \right ] = ( n - 1 ) ! \\$.这个式子很显然,我们现在有一个长度为$n - 1$的环,想要往里插入第$n$个数有$n - 1$种选择,所以我们有:$\left [ \begin{array}{ c } n \ 1\end{array} \right ] = \left [ \begin{array}{ c } n - 1 \ 1\end{array} \right ] ( n - 1 ) \\$,数学归纳一下即可.

那么前半部分的组合意义就是:考虑将$n + 1$个数划分成$m + 1$个环,我们先将其中$k$个数划分成$m$个环,剩下$n + 1 - k$个数划分成另一个环.但是这样算显然会算重,所以我们只需要勒令第$n + 1$个数在最后一个环里即可.该证明就显然了.

而由于$C_n^k ( n - k ) ! = C_n^{ n - k } ( n - k ) ! = n^{ \underline{ n - k } } = \frac{ n ! }{ k ! } \\$.因此后半部分也得证.

$\left \{ \begin{array}{ c } n + m + 1 \ m\end{array} \right \} = \sum_{ k = 0 }^m k \left \{ \begin{array}{ c } n + k \ k\end{array} \right \} \\$.

$\left [ \begin{array}{ c } n + m + 1 \ m\end{array} \right ] \sum_{ k = 0 }^m ( n + k ) \left [ \begin{array}{ c } n + k \ k\end{array} \right ] \\$.

证明:

先考虑前者,我们将$n + k$个位置分到$k$个集合之后.还剩下$( n + m + 1 ) - ( n + k ) = ( m - k + 1 )$个数,剩下$( m - k )$个集合.

拿出来$( n + k + 1 )$这个数,剩下的数刚好够每个集合放一个.最后枚举一下把$( n + k + 1 )$放在哪里即可.由于每个划分一定存在一段(可能是$0$)单独自己集合的后缀.所以这个递推成立.后者也可以同样证明.

- $C_n^m ( n - 1 )^{ \underline{ n - m } } = \sum_{ k = m }^n \left [ \begin{array}{ c } n \ k\end{array} \right ] \left \{ \begin{array}{ c } k \ m\end{array} \right \} \\$.

证明:

考虑$( n - 1 )^{ \underline{ n - m } } = \frac{ ( n - 1 ) ! }{ ( m - 1 ) ! } \\$,不妨设$f ( n , m ) = \sum_{ k = m }^n \left [ \begin{array}{ c } n \ k\end{array} \right ] \left \{ \begin{array}{ c } k \ m\end{array} \right \} \\$,相当于将$n$个数分成非空$m$组,然后组内的数要形成若干轮换的方案数.那么知道$f ( n , m ) = f ( n - 1 , m - 1 ) + ( n - 1 + m ) f ( n - 1 , m ) \\$.

设$g ( n , m ) = C_n^m \frac{ ( n - 1 ) ! }{ ( m - 1 ) ! } = \frac{ n ! ( n - 1 ) ! }{ m ! ( n - m ) ! ( m - 1 ) ! } \\$,那么知道:

显然$g ( n , m ) = g ( n - 1 , m - 1 ) + ( n - 1 + m ) g ( n - 1 , m ) \\$,数学归纳即可.

$C_n^m = \frac{ n ! }{ m ! ( n - m ) ! } = \sum_{ k = m }^n \left \{ \begin{array}{ c } n + 1 \ k + 1\end{array} \right \} \left [ \begin{array}{ c } k \ m\end{array} \right ] ( - 1 )^{ m - k } \\$.

$n^{ \underline{ n - m } } = \frac{ n ! }{ m ! } = \sum_{ k = m }^n \left [ \begin{array}{ c } n + 1 \ k + 1\end{array} \right ] \left \{ \begin{array}{ c } k \ m\end{array} \right \} ( - 1 )^{ m - k } , 其 中 m \leq n \\$.

证明:考虑(5)(6),对其做一遍斯特林反演即可.

$\left \{ \begin{array}{ c } n \ l + m\end{array} \right \} C_{ l + m }^l = \sum_{ k = l }^n \left \{ \begin{array}{ c } k \ l\end{array} \right \} \left \{ \begin{array}{ c } n - k \ m\end{array} \right \} C_n^k \\$.

$\left [ \begin{array}{ c } n \ l + m\end{array} \right ] C_{ l + m }^l = \sum_{ k = l }^n \left [ \begin{array}{ c } k \ l\end{array} \right ] \left [ \begin{array}{ c } n - k \ m\end{array} \right ] C_n^k \\$.

证明:先考虑前者,左边即先将$n$个数分为$l + m$个集合,然后再挑出$l$个集合.那不妨枚举这$l$个集合中是哪些数,然后再进行分配.后者同理.

欧拉数

记$\left \langle \begin{array}\ n \ k\end{array} \right \rangle$表示$\{ 1 , 2 , . . . , n \}$的排列$a$中满足这条性质的排列个数:存在且只存在$k$个升高,换句话说,存在且只存在$k$个$i$,满足$1 \leq i < n$,$a_i < a_{ i + 1 }$.不难发现$\left \langle \begin{array}\ n \ k\end{array} \right \rangle = \left \langle \begin{array}\ n \ n - k - 1\end{array} \right \rangle$.

考虑在一个$\{ 1 , 2 , . . . , n - 1 \}$的排列中插入$n$,设插入的位置是原本$a_i$的后面,那么要么原本$a_i < a_{ i + 1 }$,要么反之.前者不会改变排列的升高的数量,后者则会增加$1$.另外还有一种情况是插入到了序列最前面.于是我们自然得到:$\left \langle \begin{array}\ n \ k\end{array} \right \rangle = ( k + 1 ) \left \langle \begin{array}\ n - 1 \ k\end{array} \right \rangle + ( n - k ) \left \langle \begin{array}\ n - 1 \ k - 1\end{array} \right \rangle$.

特别地,我们令$\left \langle \begin{array}\ 0 \ k\end{array} \right \rangle = [ k = 0 ]$,若$k < 0$,则$\left \langle \begin{array}\ n \ k\end{array} \right \rangle = 0$.

欧拉数与二项式系数

我们有Worpitzky恒等式:

还有另一个恒等式:

剩下的不会了.

伯努利数

定义$B_j$为第$j$个伯努利数,且满足$\sum_{ j = 0 }^m \binom{ m + 1 }{ j } B_j = [ m = 0 ] , m \geq 0 \\$.

定义$S_m ( n ) = \sum_{ i = 0 }^{ n - 1 } i^m$.

伯努利数满足公式:$S_m ( n ) = \cfrac{ 1 }{ m + 1 } \sum_{ k = 0 }^m \binom{ m + 1 }{ k } B_k n^{ m + 1 - k } \\$.

证明如下:

对$S_{ m + 1 } ( n )$使用扰动法,我们有:

接下来使用数学归纳,假设$0 \leq j < m$时该公式成立,并假设有$S_m ( n ) = \cfrac{ 1 }{ m + 1 } \sum_{ k = 0 }^m \binom{ m + 1 }{ k } B_k n^{ m + 1 - k } + \Delta \\$,我们只需要证明$\Delta = 0$.

显然$\Delta = 0$,上式成立.

斐波那契数

定义斐波那契数$F_n = \begin{cases}0 & n = 0 \ 1 & n = 1 \ F_{ n - 1 } + F_{ n - 2 } & n > 1\end{cases}$.

斐波那契数的扩展定义

首先根据数学归纳,不难证明卡西尼恒等式:

事实上,如果我们将斐波那契数的递推式改写作:$F_n = F_{ n + 2 } - F_{ n + 1 }$,我们可以在$n \in \mathbb{ Z }$的时候定义斐波那契数,同样也是满足上面的恒等式的,而且我们可以发现:

斐波那契数与数论

如果我们考虑不断使用斐波那契递推式展开,不难发现:

另外,如果我们在上面这个式子中取$k = wn , w \in \mathbb{ N }$并使用归纳法,我们又可以得到一个性质:$F_{ kn }$是$F_n$的倍数,$k \in \mathbb{ Z }$.

再观察这个式子,使用归纳法可以证明$\gcd ( F_{ n } , F_{ n - 1 } ) = 1$,进一步有:$\gcd ( F_{ n + m } , F_m ) = \gcd ( F_n , F_m )$.

如果我们推广这个结论,就可以得到一个重要的性质:

如果我们再一次推广这个结论,可以得到马蒂亚舍维奇引理:

这个引理的证明如下:

由于$F_{ n + 1 } \equiv F_{ n - 1 } \pmod{ F_n }$.于是我们有:$F_{ 2 n } = F_n F_{ n + 1 } + F_{ n - 1 } F_n$,也就是$F_{ 2 n } \equiv 2 F_n F_{ n + 1 } \pmod{ F_n^2 }$.

另外我们有:$F_{ 2 n + 1 } \equiv F_{ n + 1 }^2 \pmod{ F_n^2 }$.

同理,使用归纳法可以证明:$F_{ kn } \equiv kF_n F_{ n + 1 }^{ k - 1 } \pmod{ F_n^2 } , F_{ kn + 1 } \equiv F_{ n + 1 }^k \pmod{ F_n^2 }$.

而$F_{ n + 1 } \bot F_n$,于是$F_{ kn } \equiv 0 \pmod{ F_n^2 } \Leftrightarrow k \equiv 0 \pmod{ F_n } , n > 2$.

斐波那契数系

我们如果定义$j \gg k \Leftrightarrow j \geq k + 2$,那么有齐肯多夫定理:

每个正整数都有唯一的表示方式满足:$n = \sum_{ i = 1 }^r F_{ k_i } , \forall 1 \leq i < r , k_i \gg k_{ i + 1 } \gg 0$.

首先证明存在性:我们考虑数学归纳,对于一个数n,如果$\exists k$满足$F_k = n$,则显然成立,不然,应$\exists k$满足$F_k < n < F_{ k + 1 }$,而$n - F_k$的表示已经存在了.另外,由于$n - F_k < F_{ k + 1 } - F_k = F_{ k - 1 }$,因此必定不可能出现选了$F_k$又选了$F_{ k - 1 }$的情况,存在性得证.

至于唯一性,如果我们不选择$F_k$而是选择$F_{ k - 1 }$,那么显然接下来无论怎么选,它们的加和都不可能大于等于$F_k$,因此一定是唯一的.

这样的话,我们可以将一个自然数$n$以斐波那契数的形式表示出来.

斐波那契数的封闭形式

使用生成函数,令$F ( z ) = \sum_{ k \geq 0 } F_k z^k$.那么不难发现$F ( z ) - zF ( z ) - z^2 F ( z ) = z$,也就是$F ( z ) = \cfrac{ z }{ 1 - z - z^2 }$.

考虑这个形式一定可以分解为$F ( z ) = \cfrac{ a }{ 1 - \alpha z } + \cfrac{ b }{ 1 - \beta z }$的形式,而这两种形式对应的生成函数都很显然.

进行因式分解,如果令$\phi = \cfrac{ 1 + \sqrt{ 5 } }{ 2 } , \hat \phi = \cfrac{ 1 - \sqrt{ 5 } }{ 2 }$,那么可以得到$F_n = \cfrac{ 1 }{ \sqrt{ 5 } } ( \phi^n - \hat \phi^n )$.

另外,由于$\hat \phi^n$的影响很小,于是又有$F_n = \lfloor \cfrac{ \phi^n }{ \sqrt{ 5 } } + 0 . 5 \rfloor$.

连项式

连项式多项式$K_n ( x_1 , x_2 , . . . , x_n )$定义为:$K_n ( x_1 , x_2 , . . . , x_n ) = \begin{cases}1 & n = 0 \ x_1 & n = 1 \ x_n K_{ n - 1 } ( x_1 , x_2 , . . . x_{ n - 1 } ) + K_{ n - 2 } ( x_1 , x_2 , . . . , x_{ n - 2 } ) & n \geq 2\end{cases}$.

通过定义不难发现:$K_n ( 1 , 1 , . . . , 1 ) = F_{ n + 1 }$.

继续观察式子,会发现它递归的过程相当于枚举是否消掉相邻的一对数$( x_{ n - 1 } , x_n )$.我们考虑用这样一种形式的字符串来表示最后某一项的情况:’.’为还没有消除掉的项,长度为$1$;’-‘为已经消除了的两项,长度为$2$.那么$K_n ( x_1 , x_2 , . . . , x_n )$就可以表示为一个长度为$n$的字符串,其中若有$k$个’-‘,有$n - 2 k$个’.’,则有$\binom{ n - k }{ k }$种不同的排列方式.

于是我们有:

另外,这也导出:$F_{ n + 1 } = \sum_{ k = 0 }^n \binom{ n - k }{ k } \\$.

考虑上面的构造过程,不难发现$K_n ( x_1 , x_2 , . . . , x_n ) = K_n ( x_n , x_{ n - 1 } , . . . , x_1 )$.

于是递归式可以写成:$K_n ( x_1 , x_2 , . . . , x_n ) = x_1 K_{ n - 1 } ( x_2 , x_3 , . . . x_{ n } ) + K_{ n - 2 } ( x_3 , x_4 , . . . , x_{ n } )$.

进一步地,不断展开后得到:

另外,根据连项式的定义,不难导出$K_n ( x_1 , . . . , x_n + y ) = K_n ( x_1 , . . . , x_n ) + K_{ n - 1 } ( x_1 , . . . , x_{ n - 1 } ) y$.

由这个公式可以推出:$\cfrac{ K_{ n + 1 } ( a_0 , . . . , a_n ) }{ K_n ( a_1 , . . . , a_n ) } = \cfrac{ K_n ( a_0 , . . . , a_{ n - 1 } + \cfrac{ 1 }{ a_n } ) }{ K_{ n - 1 } ( a_1 , . . . , a_{ n - 1 } + \cfrac{ 1 }{ a_n } ) }$.

不断做这个迭代,于是我们可以得到连项式与连分数之间的关系:

另外,这个与数论中的Stern-Brocot树有很大关系,暂略.

简单乐理

前言

这个博客是北京大学课程《音乐与数学》的相关笔记.然而我懒得画五线谱以及插入钢琴图片,所以这里我们只空谈理论.

本人在大学前并未学过相关乐理,所以下面的个人理解当然可能会出错.

泛音列

拍音理论

假设两个正弦单音的频率分别是$\omega , \omega + \delta$,那么它们叠加后是:

注意到这个声音受到$\cos ( \pi \delta t )$的控制.因此会以$\frac{ \delta }{ 2 }$的频率振动,由于$\delta$应该远小于$\omega$,这里就会产生$\delta = | \omega_1 - \omega_2 |$个拍音.

Mersenne定律

考虑弦乐的情况,将一根弦理想化后,可以只关注它的三个参数:

弦长$L$.

张力$T$.

线密度$\rho$.

对于弦的振动解微分方程,这里我不是很想解了啊!所以我们直接放结论,对于弦上一个点$u ( x , t )$,首先是一维振动方程:

最终得到的会是一个无穷级数,这个无穷级数的每一项都形如:

其中第$n$项的频率满足:

其中我们将$f_1$称为基频,相应的声音称为基音,而将剩下的频率对应的声音统称为泛音,其中$f_n , n \geq 2$对应的是第$n - 1$泛音.

特别地,如果我们干脆记$f = f_1$,上述结果告诉我们弦的振动产生的一列频率是:

这个序列通常被称为泛音列.

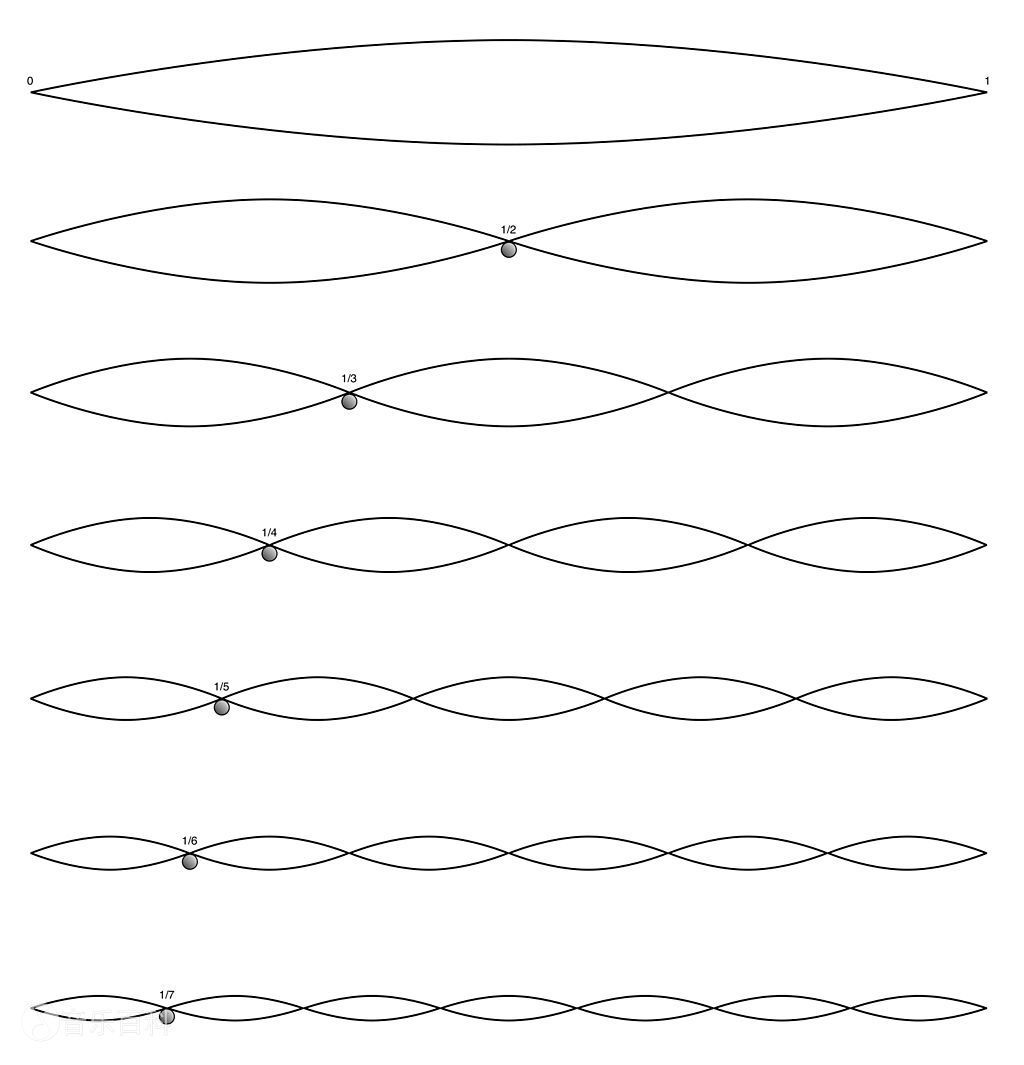

特别地,上述的频率其实是固定了点来讨论的,实际上的泛音要更为复杂,会在一根弦上的不同位置处产生不同的加权.实际上对于不同的$n$,它们的泛音列长这个样子:

其中标注的点(波节)在振动中均是固定不变的.

这其实是某些弦乐演奏中一些按弦技巧的基础.例如这里,如果我用手轻触中间点,我就可以消灭掉所有的$f_{ 2 k + 1 }$,泛音列中只剩下$2 f , 4 f , \cdots$.我们后面会再提这个事,这意味着我弹出的音高了八度.那如果我按$\frac{ 1 }{ 3 }$处呢?那泛音列中就会只剩下$3 f , 6 f , 9 f , \cdots$,也就是先高一个纯八度,再高一个纯五度.

还有拨弦,如果我在中间拨弦会发生什么呢?由于我的拨动使得整个弦应该以中间为对称形成一个偶函数,中间的点一定在波动,因此泛音列中剩下的就会是$f , 3 f , 5 f , \cdots$.

管乐器

管乐器中振动的变为空气柱,不过吧空气柱这个东西振动的时候会略微超出管口,因此会有管口矫正这个事存在.

再就是,管乐器其实分为两种:开管(两面开口)和闭管(单面开口).而且不像琴弦的两端是固定的.一个自然的想法是,根据上面我们放的那张图,开口的那个位置一定要振动,而闭口的那个位置一定被卡住不动.这意味着开管和闭管的泛音列天然不同.具体来说:

开管的泛音列:

闭管的泛音列:

另外,相同长度的管,开管的基音比闭管高了一个八度.

管乐器有一种演奏方式是超吹.简单来说,当你用力吹的时候,直觉上随着你用力越大,你吹出来的音的频率应该是连续的.但实际上听感更接近于离散的.这是因为从一开始整个泛音列就都是存在的,只是当气流加快的时候,后面的音在某种程度上被”加强”了,所以对于开管来说,你会先听到一个高八度的音,再听到一个高五度的音.

泛音列重合理论

既然如此,我们可以见到,当两个音的基频的比较为简单的时候,它们产生的泛音列重合程度就会较高.例如:

或是:

这从相当的程度解释了为什么理想的音程全都是简单整数比.

律制

要讲律制,首先要知道从经验上来讲,人耳对于音乐的听觉其实并非线性.换言之,当你听两个音的时候,你关注的可不是它们之间的频率差值,而可能更关注它们之间的频率比值.类似地,其实人听声压的时候靠的也是比值,例如分贝的定义是$L_p = 20 \log_{ 10 } ( \frac{ p }{ p_0 } )$,其中$p_0 = 20 \mu Pa$.

音程

我们称两个音级之间的距离为音程,其中高的音称为冠音,而低的音被称为根音,一个音程应该由两个参数决定:度数和半音数,简单来说,度数是跨越的音名数量,而半音数是跨越的半音数量.表格长这样:

| 度数 | 半音数 | 名称 |

| —— | ——— | ——— |

| 一 | 0 | 纯一度 |

| 二 | 1 | 小二度 |

| 二 | 2 | 大二度 |

| 三 | 3 | 小三度 |

| 三 | 4 | 大三度 |

| 四 | 5 | 纯四度 |

| 四 | 6 | 增四度 |

| 五 | 6 | 减五度 |

| 五 | 7 | 纯五度 |

| 六 | 8 | 小六度 |

| 六 | 9 | 大六度 |

| 七 | 10 | 小七度 |

| 七 | 11 | 大七度 |

| 八 | 12 | 纯八度 |

从这套理论出发,毕达哥拉斯说我们找一下最简整数比:注意到:

| 音程 | 频率比 |

| ——— | ——— |

| 纯八度 | $2 : 1$ |

| 纯五度 | $3 : 2$ |

| 纯四度 | $4 : 3$ |

| 大三度 | $5 : 4$ |

| 小三度 | $6 : 5$ |

看上去太漂亮了对吧!但是就是这个规定出了大锅.

五度相生律

中国的三分损益法和毕达哥拉斯的五度相生法其实是类似的东西,我们这里只考虑五度相生律.

毕达哥拉斯学派说,我们这么干,规定$C$的频率(当时其实不存在频率的概念,但我们这里就为了方便这么说了)为$1$,然后每次向上升一个纯五度,如果超出去了呢,那就降一个八度降回来.回忆到纯五度是七个半音,这相当于求$\{ 7 k \} \pmod{ 12 }$这个数列对吧,简单数论知识告诉我们它必然能遍历$12$种情况,具体而言:

我们是拿纯八度和纯五度生成的所有的音,因此纯五度肯定是准的,那么与之对应的纯四度肯定是准的.但是看三度音程就会发现问题,例如大三度$CE$的比是$\frac{ 81 }{ 64 } > \frac{ 80 }{ 64 } = \frac{ 5 }{ 4 }$.

更难过的是就算我们按照纯八度和纯五度生成的,这个纯八度也有点难绷.具体而言这里的$# E \ne F$,你对着这个$# E$往上再升一个音得到的理应是$C ‘ = \frac{ 3^{ 12 } }{ 2^{ 18 } } > 2$,具体来说$\frac{ 3^{ 12 } }{ 2^{ 19 } } \approx 1 . 013643$,这就出事了,这个东西转一圈并没有转到理想的纯八度音阶上,这个问题在中国古代的三分损益上也体现了,那里的名字叫旋宫不归,这里的话则是将这个略大于$1$的数叫做毕达哥拉斯音差.

仔细分析一下就会发现这个问题几乎是不可避免的,因为你上升$12$个纯五度,再下降$7$个纯八度理应回到原点,可是:

这下这下了.

纯律

其实我们刚才就能见到真正完美符合简单整数比的律根本调不出来.但是能不能让一些常用的音程(比如纯八度,纯五度,纯四度,大三度)尽可能准呢.这就是纯律在干的事.

还是规定$C$的频率为$1$.接下来用正三和弦(一个大三度和一个小三度)$I : C - E - G$,$IV : F - A - C ‘$,$V : G - B - D ‘$的比例是$4 : 5 : 6$确定剩下的:

所以现在大三度和小三度都准了.但问题又来了:

五度音程$D - A$不协和,比例为$\frac{ 80 }{ 54 } < \frac{ 81 }{ 54 } = \frac{ 3 }{ 2 }$.这直接导致了转调会出错.

有两种不同的大二度:音程$C - D , F - G , A - B$的比例是$\frac{ 9 }{ 8 }$而音程$D - E , G - A$的比例为$\frac{ 10 }{ 9 }$.

谐调音差:从$C$出发升高四个纯五度,降低两个八度和一个大三度后,得到的是:$( \frac{ 3 }{ 2 } )^4 \times ( \frac{ 1 }{ 2 } )^2 \times \frac{ 4 }{ 5 } = \frac{ 81 }{ 80 } = 1 . 0125 > 1$.

十二平均律

既然我们一开始就说了律是根据比值来定的,为什么不直接简单一点,干脆用$\sqrt[12]{ 2 }$来平均律制呢?于是将近五百年前就有了朱载堉这位手开十二次根号的神人.这也是所有律法中几乎最简单的一种了,以至于我到这里发现没啥可写的了.

但它的问题也是最一眼能看出来的,那就是除了纯八度,全都不准.

先在这里定义音分的概念,设两个声音的频率分别是$f_1 , f_2$,则它们的音分数定义为$1200 \log_2 ( \frac{ f_2 }{ f_1 } )$,容易见到十二平均律拿到的一个半音恰好是$100$音分.

用音分可以迅速确定一下,发现十二平均律这玩意准的离谱,虽然哪里都差一点,但哪里差的都不多.

调式

大小调

自然大调

就是我们最常用的$CDEFGABC ‘$,用大二度和小二度组织调式.具体而言,以一个大二度分开了两组四声音阶(均为大大小),按顺序分别为:

主音

上主音

中音

下属音

属音

下中音

导音

用五度相生,下属音$\rightarrow$主音$\rightarrow$属音.

自然小调

以一个大二度分开了两组四声音阶(分别为大小大和小大大)

以$ABCDEFG$用的调子,然而这里的问题是$G$作为导音却和$A ‘$差了个全音,导得不好.

和声小调

以一个大二度分开了两组四声音阶(分别为大小大和小增小)

将自然小调的导音升高一个半音.用$A , B , C , D , E , F , (^# G )$.

但是这样出了个增二度.

旋律小调

以一个大二度分开了两组四声音阶(分别为大小大和大大小)

把下中音也升上去,这样差的就小,用$A , B , C , D , E , (^# F ) , (^# G )$.

可以见到小调改音的主要目的是为了调导音的作用,这种作用只有在上行音阶的时候才是需要人为更改的,因此下行音阶不改音,与自然小调的下行音阶保持一致.

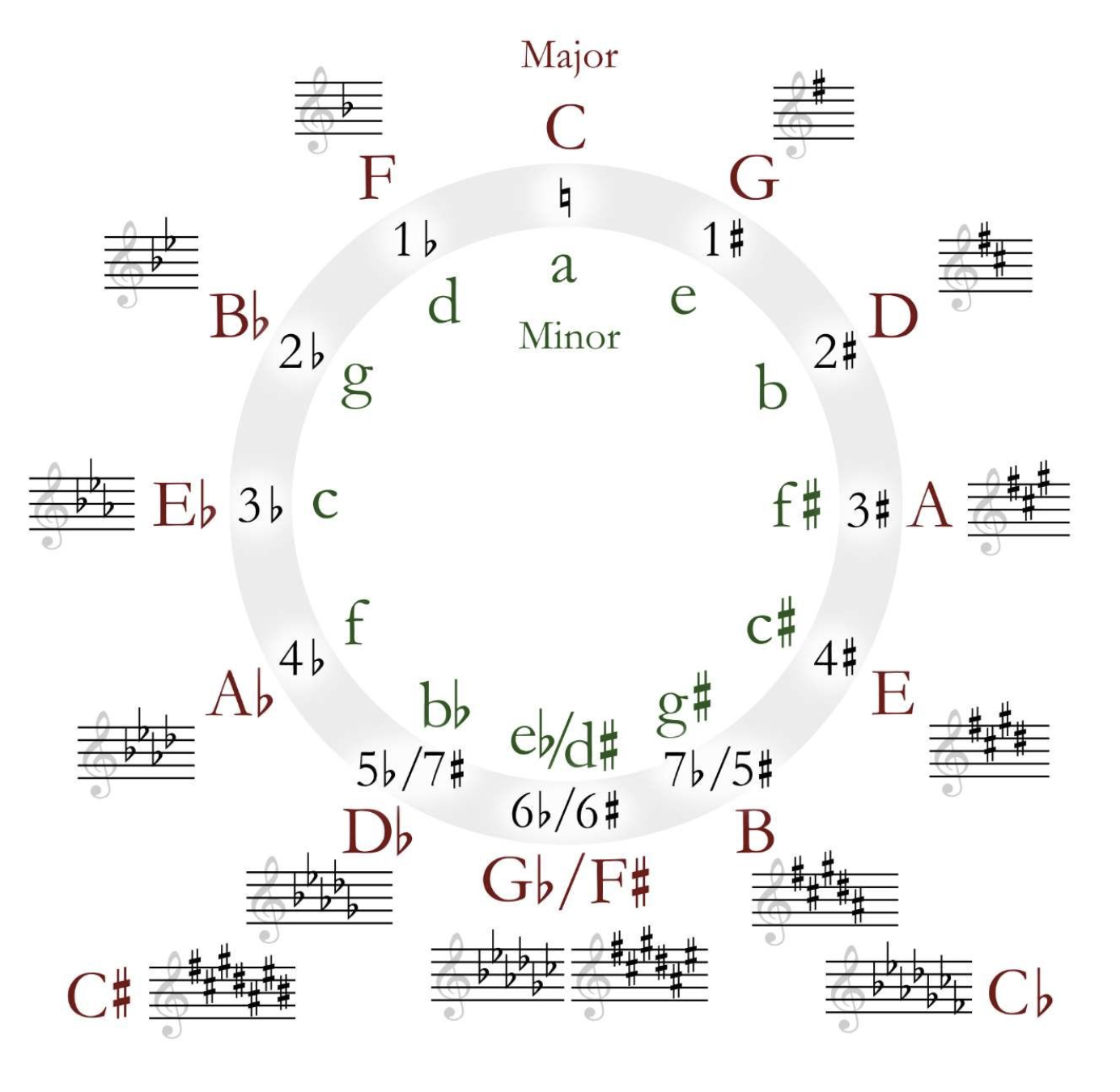

升降号调

以五度相生:

依次考虑它们为主调的自然大调音阶.

大调音阶的前后是对称的全全半+全+全全半结构,跳一个五度刚好能从前半部分跳到后半部分,因此从$C$开始每次往后跳一次都要在一个音阶上增一个升号.从$C$大调提升到$G$大调的时候就是将$C$的下属音(也就是$F$)升音.

对称地,反方向的五度相生:

那这个应该降什么呢?比如从$C$大调提升到$F$大调的时候就是将$F$的下属音$B$降一个音对吧.

所以最后的结果就是:

一个自然大调将主音向前挪小三度就得到了一个自然小调,它们称为一对关系大小调.

具有相同主音的大小调被称为平行大小调.其实也就是名字精确到大小写是一样的.

一个大调的下属音大调和属音大调以及对应的关系小调称为其近关系调.

和弦

三和弦

按照三度音程叠起来的三个音所构成的和弦被称为三和弦.其中最下面的音被称为根音,最上面的音被称为冠音或者五音,中间的被称为三音.

由于三度音程分大小,所以就有了四种不同的三和弦.

大三和弦:下面一个大三度,上面一个小三度,刚好形成$4 : 5 : 6$的频率关系.

小三和弦:下面一个小三度,上面一个大三度.

减三和弦:两个小三度.

增三和弦:两个大三度.

七和弦

按照三度音程叠四个音构成的和弦被称为七和弦.除去其中由三个大三度构成的(这样使得最上方的七音和最底下的根音形成了八度)以外,其余七种七和弦依照三和弦名称+七度音阶名称的原则命名,如下:

减减七和弦(减七和弦):小小小.

减小七和弦(半减七和弦):小小大.

小小七和弦(小七和弦):小大小.

小大七和弦:小大大.

大小七和弦(属七和弦):大小小.

大大七和弦(大七和弦):大小大.

增大七和弦:大大小.

很遗憾的是七和弦全部包含至少一个不协和音程,所以它们全都是不协和和弦.

和弦转位

以根音为低音的和弦为原位和弦,以三五七音为低音的则称为转位和弦.

对于三和弦来说:

以三音作为低音的称为第一转位,也称作六和弦.

以五音作为低音的称为第二转位,也称作四六和弦.

对于七和弦来说:

以三音作为低音的称为第一转位,也称作五六和弦.

以五音作为低音的称为第二转位,也称作三四和弦.

以七音作为低音的称为第三转位,也称作二和弦.

和弦的调性

在调式的主音,下属音,属音上的和弦分别被称为主和弦(I),下属和弦(IV),属和弦(V),它们被统称为正和弦,在C大调中体现为$C - E - G$,$F - A - C ‘$,$G - B - D ‘$.其中主和弦一般比较稳定,属和弦则比较飘渺,下属和弦往往则起到过度作用.

一定范围内的和弦连接被称为和声进行,下面是三种基本形式:

正格进行:$I \to V \to I$.

变格进行:$I \to IV \to I$.

复式进行:$I \to IV \to V \to I$.

对于大调来说,其不同的三和弦之间有更加复杂的关系.经验给出以下图表:

其中$I$较为特殊,可以走向全部的和弦,这里略去不画.

新黎曼理论

引入以下三种对三和弦的变换(均会使得大和弦变小和弦,小和弦变大和弦):

平行变换$P$:保持纯五度音阶不变,将三音切换.

关系变换$R$:保持大三度音阶不变,补上剩下的一个(等价于大小调转换).

导音变换$L$:保持小三度音阶不变,补上剩下的一个.

容易见到$R \circ ( L \circ R )^3 = P$.

随机算法

随机化算法

基本分析

Union Bound

即:$Pr [ \bigcup_i X_i ] \leq \sum Pr [ X_i ]$,取等当且仅当所有$X_i$互斥.

Markov 不等式

若$X \geq 0$,则$Pr [ X \geq t \mathbb{ E } [ X ] ] \leq \frac{ 1 }{ t }$.

Example(Max-Cut算法)

一个无向无权图,将点集划分成两个部分,使得跨越这两部分的边尽可能多.

直接随机划分,容易见到每条边有$\frac{ 1 }{ 2 }$的概率是割边,因此期望自然是$\frac{ 1 }{ 2 } | E | \geq \frac{ 1 }{ 2 } | \text{ max - cut } |$.

由此立即见到,$Pr [ | ans | \leq ( \frac{ 1 }{ 2 } - \epsilon ) | E | ] = Pr [ | E | - | ans | \geq ( \frac{ 1 }{ 2 } + \epsilon ) | E | ] \leq \frac{ 1 }{ 1 + 2 \epsilon }$.

由于每次独立操作,因此如果有$P$的概率失败,那么运行$T$次后至少成功一次的概率应当为$1 - P^T$.从而$T = O ( \log_P{ \delta } ) = O ( \cfrac{ \ln \frac{ 1 }{ \delta } }{ \ln ( 1 +{ 2 \epsilon } ) } ) \approx O ( \cfrac{ \ln \frac{ 1 }{ \delta } }{ \epsilon } )$即可拿到$\delta$失败概率.

Chernoff Bound

设$X_1 , \cdots , X_n \in [ 0 , 1 ]$是独立,同期望(期望为$\mu \geq t$)的随机变量,令$X = \frac{ \sum_k X_k }{ n }$,对于任何失败概率$\delta \in ( 0 , 1 )$,应当有:

Example(Median Trick)

现在有一个黑盒能够以$p > \frac{ 1 }{ 2 }$的概率正确回答Yes或者No,问重复$T$选多少次能拿到$1 - \delta$的成功概率.

考虑重复$T$次后应当有期望$pT$个正确答案,因此直接取中位数.称此算法为Median Trick.

Chernoff Bound 告诉我们$T = O ( \log \frac{ 1 }{ \delta } )$足够.

Hoeffding 不等式

设独立随机变量$x_1 , \cdots , x_m \in [ s , t ]$,令$X = \sum_i x_i$,则:

编程中的随机性

一般采用伪随机,也即是给定初值$X_0$,通过某个确定性的函数来生成$X_{ n + 1 } = f ( X_n )$这样的.

数值概率算法

即通过随机选取元素从而求得在数值上的近似解.较之于传统算法,其运行速度更快,而且随着运行时间的增加,近似解的精度也会提高.在不可能或不必要求出问题的精确解时,可以使用其得到相当满意的近似解,如随机撒点法(近似求难以计算的图形面积).

Monte Carlo算法

总是能在确定的运行时间内出解,但是得到的解有一定概率是错的.通常出错的概率比较小,因此可以通过反复运行算法来得到可以接受的正确率.

求解最优化问题的Monte Carlo算法

事实上,大部分最优化问题都可以转化为判定性问题:也就是判定一个解是否是最优解,因此我们接下来基本都是讨论的求解判定性问题的Monte Carlo算法.

求解判定性问题的Monte Carlo算法

假倾向的Monte Carlo算法:当这类算法的返回值为假的时候,结果一定正确,但返回值为真的时候则有一定概率错误.

真倾向的Monte Carlo算法:当这类算法的返回值为真的时候,结果一定正确,但返回值为假的时候则有一定概率错误.

产生双侧错误的Monte Carlo算法:无论返回值为什么都有概率出错.基本不会使用.

以下讨论的Monte Carlo算法均为产生单侧错误的Monte Carlo算法.

正确率与复杂度

显然,如果我们有一个单词正确率为$p$,时间复杂度为$O ( f ( n ) )$的算法,我们运行其$k$次,则正确率为$1 - ( 1 - p )^k$,时间复杂度为$O ( kf ( n ) )$.

算法设计思路1

我们来总结一下通常的Monte Carlo算法的设计思路:

设计一个能解决问题的确定性算法

这个算法需要枚举一些元素.

设这个算法的复杂度为$O ( f ( n ) g ( n ) )$,其中$f ( n )$为枚举部分的复杂度,$g ( n )$为单词枚举中计算所需的复杂度.大部分情况下应保证$g ( n )$不会很大.

向算法引入随机化优化复杂度

随机化寻找元素来降低复杂度.

计算随机化情况下的正确率以及复杂度.

算法设计思路2

设计一个能解决问题的确定性算法

这个算法需要用到一个或多个传入的元素.

这个元素的值不应该依赖于输入数据.

我们可以通过check这个元素来得到与答案有关的信息.

向算法引入随机化优化复杂度

随机这个元素.

计算随机化情况下的正确率以及复杂度

Example

Example 1(Millar-Rabin算法)

略

Example2(CodeChef MSTONE)

平面上有$n$个互不重合的点,已知存在不超过$7$条直线可以覆盖全部的点,问在平面上作一条直线,最多能覆盖多少个点.$n \leq 10000$.

考虑一个朴素的暴力:枚举两个点,确定一条直线,然后判断多少个点在这条直线上.但是这样复杂度是$O ( n^3 )$的.